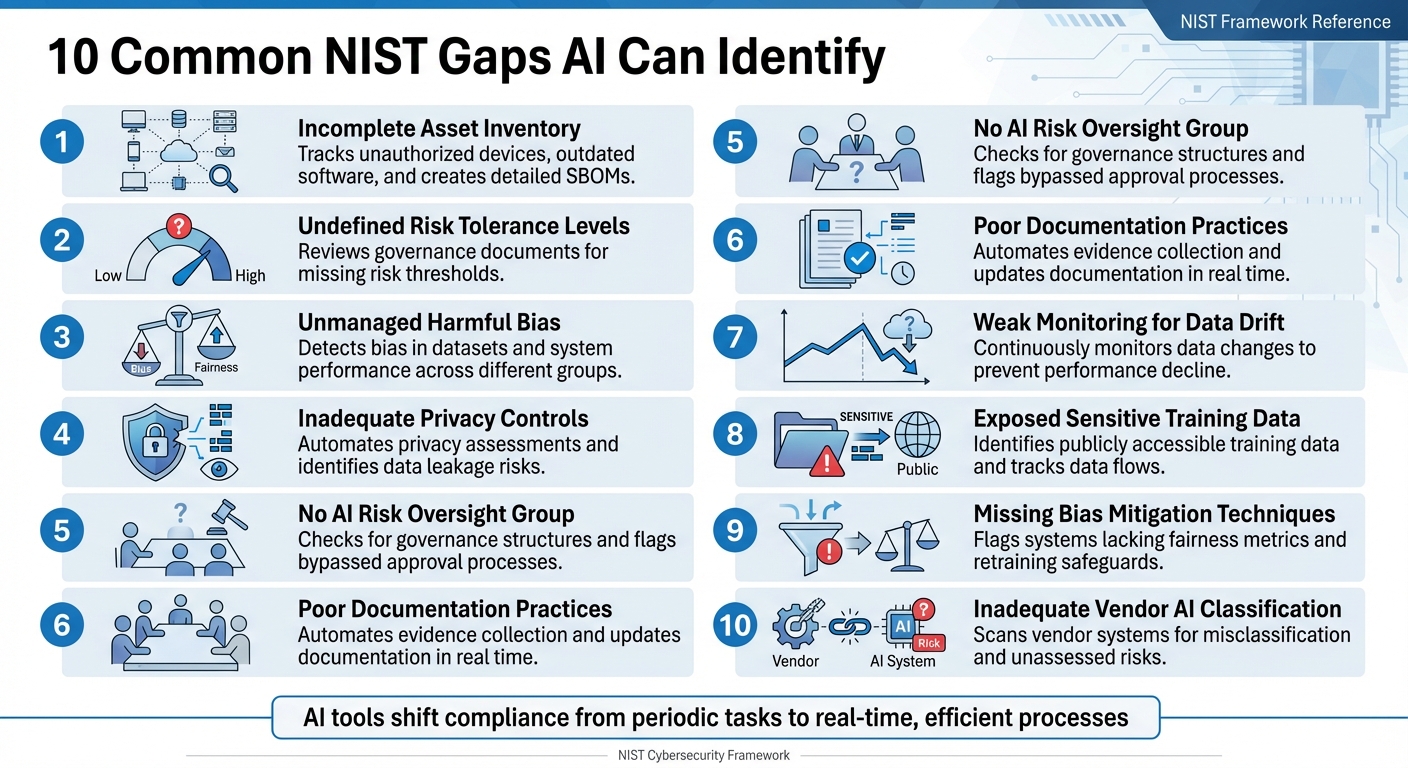

Unternehmen haben oft Schwierigkeiten, die vollständige Konformität mit dem NIST Cybersecurity Framework (CSF) zu erreichen, insbesondere mit dessen neuester Version, CSF 2.0. Manuelle Audits sind langsam und fehleranfällig, sodass Lücken in Bereichen wie Asset-Tracking, Risikomanagement und Datenschutzkontrollen entstehen. KI-gestützte Tools ändern dies, indem sie Konformitätsprüfungen automatisieren, eine kontinuierliche Überwachung ermöglichen und Lücken in Echtzeit identifizieren. Hier sind 10 häufige Lücken in der NIST-Konformität, die mit KI geschlossen werden können:

- Unvollständige Bestandsaufnahme der Vermögenswerte: KI verfolgt nicht autorisierte Geräte und veraltete Software und erstellt detaillierte Software-Stücklisten (SBOMs).

- Unbestimmte Risikotoleranzstufen: KI überprüft Governance-Dokumente auf fehlende Risikoschwellenwerte.

- Unkontrollierte Voreingenommenheit: KI erkennt Voreingenommenheit in Datensätzen und der Systemleistung über verschiedene Gruppen hinweg.

- Unzureichende Datenschutzkontrollen: KI automatisiert Datenschutzbewertungen und identifiziert Risiken wie Datenlecks.

- Keine KI-Risikoüberwachungsgruppe: KI überprüft Governance-Strukturen und meldet umgangene Genehmigungsprozesse.

- Mangelhafte Dokumentationspraktiken: KI automatisiert die Beweissicherung und aktualisiert die Dokumentation in Echtzeit.

- Schwache Überwachung von Datenabweichungen: KI-Tools überwachen kontinuierlich Datenänderungen, um Leistungseinbußen zu verhindern.

- Offengelegte sensible Trainingsdaten: KI identifiziert Risiken wie öffentlich zugängliche Trainingsdaten und verfolgt Datenflüsse.

- Fehlende Techniken zur Verringerung von Verzerrungen: KI kennzeichnet Systeme, denen Fairness-Metriken und Schutzmaßnahmen für das erneute Training fehlen.

- Unzureichende KI-Klassifizierung von Anbietern: KI scannt Anbietersysteme auf Fehlklassifizierungen und nicht bewertete Risiken.

KI-Tools wie ISMS Copilot optimieren die Compliance, indem sie die Lückenanalyse automatisieren, Kontrollen an NIST-Standards ausrichten und auditfähige Dokumentationen erstellen. Dadurch wird Compliance von einer periodischen Aufgabe zu einem effizienten Echtzeitprozess.

10 häufige NIST-Compliance-Lücken, die KI identifizieren und beheben kann

GRC – Gap-Analyse 101 unter Verwendung von NIST RMF und CIS Controls Compliance

1. Unvollständige Bestandsaufnahme der Vermögenswerte

Eine gründliche Bestandsaufnahme der Assets ist entscheidend für die Erfüllung der NIST-Compliance-Anforderungen. Dennoch haben viele Unternehmen Schwierigkeiten, den Überblick über alle von ihnen verwendeten Geräte, Anwendungen und Softwarekomponenten zu behalten. Wenn Assets nicht nachverfolgt werden, entstehen Schwachstellen, die Angreifer ausnutzen können.

Ein NIST 800-53 Copilot kann Ihnen dabei helfen, indem er den tatsächlichen Zustand Ihres Netzwerks mit dem gewünschten Zustand vergleicht. Durch kontinuierliches Scannen werden Abweichungen von Ihrer genehmigten Asset-Liste hervorgehoben, sodass Probleme wie nicht autorisierte Geräte oder veraltete Software, für die wichtige Sicherheitspatches fehlen, leichter erkannt werden können. Dieser fortlaufende Prozess stärkt nicht nur das Risikomanagement, sondern liefert auch wertvolle Einblicke in die Sicherheit Ihres Netzwerks.

„Der Schwerpunkt der SWAM-Funktion liegt auf der Verwaltung von Risiken, die durch nicht verwaltete oder nicht autorisierte Software in einem Netzwerk entstehen. Nicht verwaltete oder nicht autorisierte Software ist ein Ziel, das Angreifer als Plattform für Angriffe auf Komponenten im Netzwerk nutzen können.“ – NIST IR 8011 Band 3

Über das Scannen hinaus bieten CDM-Dashboards Echtzeit-Einblick in Ihren Anlagenbestand und ersetzen veraltete, statische Audits durch kontinuierliche Überwachung. KI-Systeme können außerdem automatisch eine detaillierte Software-Stückliste (SBOM) für jede Software-Version erstellen und dabei jede Komponente und Abhängigkeit katalogisieren – egal ob direkt oder indirekt. Diese Funktion wird immer wichtiger, da fast 220.000 US-Unternehmen die CMMC-Standards einhalten müssen, wobei 80.000 von ihnen Level-2-Kontrollen unterliegen, die mit NIST SP 800-171 übereinstimmen.

Um Ihre Bestandsaufnahme zu verbessern, sollten Sie die Verwendung von Software-Identifikations-Tags (SWID) in Betracht ziehen, um die Erkennung von Software in Ihrem Netzwerk zu automatisieren. Sie können auch automatisierte Whitelists implementieren, um sicherzustellen, dass nur autorisierte Software ausgeführt werden darf. Bei KI-Systemen ist es wichtig, nicht nur die Hardware zu inventarisieren, sondern auch die Integrationen von Drittanbietern, auf die sie angewiesen sind, da diese externen Komponenten zusätzliche Risiken mit sich bringen können.

2. Nicht definierte Risikotoleranzstufen

Viele Organisationen erkennen die mit KI verbundenen Risiken, versäumen es jedoch oft, klare Grenzen für das festzulegen, was akzeptabel ist. Ohne diese definierten Grenzen kann es für Teams schwierig sein, zu entscheiden, wann sie ein Projekt vorantreiben oder pausieren sollten. Hier kommen KI-Tools ins Spiel. Mithilfe von natürlicher Sprachverarbeitung können rahmenübergreifende ISMS-Assistenten Richtlinien, Risikomanagementstrategien und Governance-Rahmenwerke überprüfen, um zu bestätigen, ob bestimmte Kriterien – wie quantitative Grenzen oder qualitative Grenzen – für verschiedene KI-Anwendungen festgelegt wurden. Beispielsweise erfordern Systeme, die mit sensiblen Daten wie personenbezogenen Daten (PII) umgehen, strengere Schwellenwerte, um Sicherheit und Compliance zu gewährleisten. Wenn diese Sicherheitsvorkehrungen fehlen, sind sofortige Korrekturmaßnahmen erforderlich, wie vom NIST betont wird.

„Solange die Herausforderungen bei der Festlegung von KI-Risikotoleranzen ungelöst bleiben, kann es Situationen geben, in denen ein Risikomanagement-Rahmenwerk noch nicht ohne Weiteres zur Minderung negativer KI-Risiken eingesetzt werden kann.“ – NIST AI RMF 1.0

Das NIST definiert Risikotoleranz als „die Bereitschaft einer Organisation oder eines KI-Akteurs, das Risiko zu tragen, um ihre bzw. seine Ziele zu erreichen“. KI-Tools spielen eine entscheidende Rolle beim Scannen von Governance-Dokumenten, um klar dokumentierte Kriterien für die Risikoakzeptanz zu überprüfen, unabhängig davon, ob es sich um numerische Grenzwerte oder umfassendere qualitative Grenzen handelt. Das am 26. Januar 2023 eingeführte NIST-KI-Risikomanagement-Framework schreibt jedoch keine bestimmten Toleranzwerte vor. Stattdessen betont es, wie wichtig es ist, Lücken zu identifizieren – wie fehlende Dokumentation zu Restrisiken oder vage Risikomanagementstrategien –, die Organisationen gefährden könnten.

Das NIST bietet eine klare Richtlinie für solche Szenarien:

„In Fällen, in denen ein KI-System inakzeptable negative Risikostufen aufweist, sollten die Entwicklung und der Einsatz auf sichere Weise eingestellt werden, bis die Risiken ausreichend beherrscht werden können.“ – NIST AI RMF 1.0

3. Unkontrollierte schädliche Voreingenommenheit

Voreingenommenheit in KI-Systemen entsteht durch das Zusammenspiel von Code, Trainingsdaten und dem breiteren sozialen Kontext. Ohne angemessene Compliance-Richtlinien können diese Systeme unbeabsichtigt bestehende Ungleichheiten verschärfen oder sogar neue Diskriminierungsmuster schaffen. Dies hat reale Konsequenzen in Bereichen wie Gesundheitswesen, Personalbeschaffung und Finanzen. Das Problem wird durch die Komplexität von KI-Systemen noch verschärft, die oft unzählige Entscheidungspunkte beinhalten, sodass es nahezu unmöglich ist, Verzerrungen manuell zu identifizieren und zu beheben. Unternehmen greifen häufig auf einen KI-Compliance-Assistenten zurück, um diese komplexen, mehrstufigen Arbeitsabläufe zu verwalten.

„Ohne angemessene Kontrollen können KI-Systeme ungerechte oder unerwünschte Ergebnisse für Einzelpersonen und Gemeinschaften verstärken, aufrechterhalten oder verschärfen.“ – NIST AI RMF 1.0

KI-Tools bekämpfen schädliche Verzerrungen durch Prozesse wie Test, Evaluation, Verification und Validation (TEVV), wie in der MEASURE-Funktion des NIST AI RMF beschrieben. Diese Prozesse bewerten, ob Trainingsdatensätze mit ihrem beabsichtigten Zweck übereinstimmen und die aktuellen gesellschaftlichen Bedingungen widerspiegeln. Dabei spielt die automatisierte Überwachung eine wichtige Rolle, indem sie „Datenabweichungen” identifiziert. Damit sind Änderungen in den Eingabedaten gemeint, die sich auf die Systemleistung auswirken und neue Verzerrungen verursachen können, die bei den ersten Tests möglicherweise noch nicht vorhanden waren.

Dieser Erkennungsprozess geht über das reine Auswerten von Zahlen hinaus. KI-Tools bewerten die Leistung von Systemen in verschiedenen Untergruppen und berücksichtigen dabei, dass auch Personen, die das System nicht direkt nutzen, davon betroffen sein können. Dieser Ansatz, der oft als soziotechnische Bewertung bezeichnet wird, berücksichtigt nicht nur das technische Design, sondern auch, wie es mit gesellschaftlichen Normen und menschlichem Verhalten interagiert und Ungleichheiten hervorruft. Um Objektivität zu gewährleisten, plädiert das NIST für eine klare Aufgabenteilung: Teams, die KI-Modelle entwickeln, sollten von denen getrennt sein, die diese Modelle überprüfen und validieren. Diese Aufstellung ermöglicht unvoreingenommene Bewertungen und eine kontinuierliche Überwachung auf Verzerrungen in allen Benutzergruppen.

Eine weitere wichtige Strategie zum Umgang mit Verzerrungen ist eine verbesserte Datenverfolgung. So berichteten beispielsweise Unternehmen, die KI-native Transparenz-Tools einsetzen, von einer erstaunlichen Steigerung ihrer Fähigkeit zur Überwachung von Datenverarbeitungsaktivitäten um 1.660 % innerhalb von nur drei Wochen nach der Implementierung. Diese Tools bilden „Datenwege” ab und verfolgen, wie Daten von ihrer Quelle durch KI-Modelle fließen. Auf diese Weise können sie potenzielle Verstöße in Echtzeit vorhersagen und verhindern. Dies ist von entscheidender Bedeutung, da KI Daten mit einer Geschwindigkeit verarbeitet, die weit über das hinausgeht, was manuelle Teams bewältigen können. Die Verfolgung dieser Datenflüsse ist unerlässlich, um Veränderungen zu erkennen, die zu neuen oder sich verschärfenden Verzerrungen führen könnten, bevor sie Schaden anrichten.

4. Unzureichende Datenschutzkontrollen

Das rasante Tempo und der Umfang von KI-Systemen machen Datenschutzlücken zu einem erheblichen Problem, zumal manuelle Kontrollen kaum Schritt halten können. Ohne angemessene Datenschutzmaßnahmen riskieren Unternehmen, personenbezogene Daten (PII) durch Lecks in Trainingsdaten, unbefugten Zugriff oder unbeabsichtigte Offenlegungen in Modellausgaben preiszugeben. Die Abhängigkeit von APIs für die Datenerfassung und -auswertung vergrößert die Angriffsfläche zusätzlich, sodass robuste Datenschutzkontrollen unerlässlich sind.

Um diesen Herausforderungen zu begegnen, automatisieren KI-Tools, darunter spezialisierte Compliance-Assistenten, nun die Bewertung von Datenschutzkontrollen mithilfe maschinenlesbarer Formate wie OSCAL. Diese Tools bewerten kontinuierlich die in Frameworks wie NIST SP 800-53 beschriebenen Kontrollen und verwenden dabei Formate wie JSON, XML und YAML. Insbesondere veröffentlichte das NIST am 27. August 2025 die Version 5.2.0 von SP 800-53, die Datenschutzkontrollen vollständig in den umfassenderen Sicherheitskontrollkatalog integrierte und sich damit vom früheren eigenständigen Ansatz entfernte.

„Die Berücksichtigung von Funktionalität und Sicherheit trägt dazu bei, dass IT-Produkte und die auf diesen Produkten basierenden Systeme ausreichend vertrauenswürdig sind.“ – Joint Task Force, NIST SP 800-53 Rev. 5

Automatisierte Tools konzentrieren sich auf die Kontrollfamilie „PII-Verarbeitung und Transparenz“ (PT), um unbefugte Nutzung, Offenlegung oder Risiken der De-Anonymisierung von personenbezogenen Daten zu identifizieren. Sie decken auch Schatten-APIs und Schatten-KI auf, die bei manuellen Audits oft übersehen werden. Durch die Implementierung von „Policy-as-Code“ können Unternehmen die komplexen Anforderungen von NIST SP 800-53 in Echtzeit-Betriebsregeln umwandeln. Dieser Prozess wird optimiert, wenn Unternehmen ihre KI-Compliance-Assistenten auf hochpräzise Modelle trainieren, die für GRC entwickelt wurden. Diese Regeln entfernen automatisch sensible Daten aus KI-Eingabeaufforderungen und -Ausgaben, bevor sie vom Modell verarbeitet werden.

Darüber hinaus unterstützt die Dioptra-Software des NIST Red-Team-Übungen und hilft Unternehmen dabei, Datenschutz- und Sicherheitskontrollen unter widrigen Bedingungen zu testen. Mit diesen Simulationen lassen sich Leistungseinbußen messen und spezifische Schwachstellen identifizieren. Dies ist besonders wichtig, da das NIST AI RMF Generative AI Profile zwölf einzigartige oder erhöhte Risiken im Zusammenhang mit KI aufzeigt, darunter Datenschutzbedenken wie Datenlecks und unbefugte De-Anonymisierung. Am 14. April 2025 unterstrich das NIST diese Probleme erneut durch die Veröffentlichung des Entwurfs des Privacy Framework 1.1, das sich speziell mit KI-bezogenen Datenschutzrisiken wie Inferenzangriffen und Bias-Verstärkung befasst.

5. Keine Gruppe zur Überwachung von KI-Risiken

Eine große Herausforderung beim KI-Risikomanagement ist das Fehlen einer speziellen Aufsichtsgruppe. Ohne ein solches Gremium geraten Governance und Rechenschaftspflicht oft ins Hintertreffen, was zu fragmentierten Maßnahmen mit geringerer Priorität führt. Heute können fortschrittliche Tools, die Natural Language Processing (NLP) nutzen, dazu beitragen, diese Lücke zu schließen, indem sie Unternehmensrichtlinien, Satzungen und Sitzungsprotokolle analysieren. Diese Tools können bestätigen, ob eine formelle KI-Risikoüberwachungsgruppe existiert, und die Übereinstimmung mit der NIST AI RMF-Funktion „Govern” sicherstellen – insbesondere mit Govern 1.2, die die Notwendigkeit klarer Governance- und Rechenschaftsstrukturen betont.

KI-gesteuerte Systeme untersuchen auch Organigramme und Identitätsmanagementsysteme, um formelle Aufsichtsrollen innerhalb des KI-Risikomanagements zu identifizieren. Governance-Plattformen bieten einen zusätzlichen Schutz, indem sie Projekte kennzeichnen, die formelle Genehmigungsprozesse umgehen. Dies gewährleistet eine kontinuierliche Aufsicht, eine wichtige Komponente für die Einhaltung des NIST RMF. Die „Govern”-Funktion dient als Grundlage und beeinflusst alle anderen RMF-Funktionen wie „Map”, „Measure” und „Manage”. Dieser vernetzte Ansatz stärkt das gesamte Rahmenwerk.

„Ohne klar definierte Verantwortlichkeiten können Maßnahmen zum KI-Risikomanagement fragmentiert oder vernachlässigt werden, wodurch das Unternehmen Risiken ausgesetzt ist.“ – Kezia Farnham, Senior Manager, Diligent

Die Dringlichkeit einer angemessenen Aufsicht wird durch das rasante Wachstum der Investitionen in KI und der Regulierung unterstrichen. Im Jahr 2024 beliefen sich die Investitionen des privaten Sektors in den USA in KI auf über 100 Milliarden US-Dollar, während die Erwähnungen von KI in globalen Gesetzgebungen seit 2023 in 75 Ländern um 21,3 % gestiegen sind – eine erstaunliche Verneunfachung seit 2016. Ohne formelle Aufsichtsmechanismen laufen Unternehmen Gefahr, gegen neue Vorschriften wie den EU-KI-Akt und die US-Verordnung 14110 zu verstoßen, die die Bedeutung der menschlichen Aufsicht und eines überprüfbaren Risikomanagements betonen.

Um diese Lücke zu schließen, sollten Unternehmen ein funktionsübergreifendes KI-Risiko-Komitee bilden, dem wichtige Führungskräfte wie der General Counsel, der Chief Information Security Officer (CISO), der Chief Risk Officer und die KI/ML-Verantwortlichen angehören. Die Übertragung der Verantwortung für das KI-RMF an einen einzigen leitenden Angestellten – häufig den Leiter der Risikoabteilung oder der Rechtsabteilung – kann die Rechenschaftspflicht weiter zentralisieren. Darüber hinaus kann die Einführung eines speziell entwickelten KI-Compliance-Assistenten diesen Prozess rationalisieren, indem er die Zuordnung von Rollen und Verantwortlichkeiten automatisiert und veraltete manuelle Tabellenkalkulationen durch kontinuierliche Überwachungssysteme ersetzt.

6. Mangelhafte Dokumentationspraktiken

Aufbauend auf früheren Problemen mit der Nachverfolgung und Überwachung von Vermögenswerten untergräbt eine unzureichende Dokumentation die Compliance-Bemühungen zusätzlich. Dokumentationslücken sind weit verbreitet und kostspielig, wenn es um die Einhaltung der NIST-Vorschriften geht. Auffallende 86 % der Unternehmen haben keinen Einblick in ihre KI-Datenflüsse, was zu erheblichen Lücken in der Dokumentation und bei Audits führt, die bei behördlichen Überprüfungen zu Problemen führen können. Wenn Auditoren beispielsweise Protokolle von KI-Interaktionen mit personenbezogenen Daten anfordern, sind viele Unternehmen nicht in der Lage, diese bereitzustellen. Dieser Verstoß verstößt gegen wichtige Vorschriften wie Artikel 30 der DSGVO, Abschnitt 1798.130 des CCPA und § 164.312 des HIPAA.

KI-gestützte Compliance-Plattformen bieten eine praktische Lösung, indem sie veraltete manuelle Tabellenkalkulationen durch Echtzeit-Dashboards ersetzen. Diese Dashboards kennzeichnen automatisch fehlende Nachweise und Probleme mit der Dokumentation. Außerdem erkennen sie durch kontinuierliche Kontrollüberwachung „Abweichungen“ – Fälle, in denen die aktuelle Dokumentation oder Richtlinien nicht mehr mit dem tatsächlichen Zustand der Systeme oder Infrastruktur übereinstimmen. Automatisierte Tools erfassen Konfigurationen und Protokolle in Echtzeit und erstellen so umfassende Prüfpfade.

„Die Behandlung jeder Änderung, jeder Bereitstellung und jedes Vorfalls als Dokumentationsereignis gewährleistet eine kontinuierliche Sammlung von Beweisen, die weitaus zuverlässiger ist als eine überstürzte Nachbearbeitung nach dem Vorfall.“ – Abnormal AI

Das Prinzip „Dokumentieren Sie während der Arbeit“ stärkt die Compliance, indem Beweise in Echtzeit erfasst werden. Durch die Integration mit Tools wie versionskontrollierten Wikis und Ticketingsystemen stellt KI sicher, dass Genehmigungen und Screenshots an Pull-Anfragen angehängt werden. Dies ist besonders wichtig, da nur 17 % der Unternehmen automatisierte KI-Sicherheitskontrollen implementiert haben, die die für behördliche Audits erforderlichen Protokolle liefern können.

Unternehmen, die automatisierte Compliance-Plattformen nutzen, profitieren von erheblichen Vorteilen, darunter die Verkürzung der Überprüfungszyklen von Wochen auf wenige Stunden und eine deutliche Verringerung des Compliance-Aufwands. Diese Tools gleichen außerdem das „aktuelle Profil” eines Unternehmens mit einem „Zielprofil” des NIST ab und zeigen Lücken in den Sicherheitsvorkehrungen und der Dokumentation auf. Durch die Automatisierung des Prozesses „Identifizieren – Bewerten – Kategorisieren” tragen sie dazu bei, dass Bestandsaufnahmen und Risikoklassifizierungen stets auf dem neuesten Stand sind. Dieser kontinuierliche Ansatz bei der Dokumentation spielt eine wichtige Rolle bei der Aufrechterhaltung der NIST-Compliance.

sbb-itb-4566332

7. Schwache Überwachung von Datenabweichungen

Datenverschiebungen treten auf, wenn sich die Daten, mit denen ein KI-System trainiert wurde, im Laufe der Zeit ändern, was zu einem Rückgang der Leistung und Zuverlässigkeit führt. Da mittlerweile über 75 % der Unternehmen KI in mindestens einem Geschäftsbereich einsetzen, stellt die Nichtüberwachung dieser Veränderungen ein ernstes Compliance-Risiko dar – ein Risiko, für dessen Bewältigung KI-gestützte Tools gut gerüstet sind. Die Bewältigung dieses Problems erfordert fortschrittlichere Überwachungslösungen, wie im Folgenden beschrieben.

In der Praxis funktioniert KI oft wie eine „Black Box“, was es schwieriger macht, Fehler zu erkennen. 45 % der Unternehmen geben an, dass Bedenken hinsichtlich der Datengenauigkeit oder Voreingenommenheit ein großes Hindernis für die Einführung von KI darstellen. Dennoch fehlen vielen noch immer die Tools für eine kontinuierliche Überwachung, sodass sie anfällig für Datenabweichungen sind. Im Gegensatz zu manuellen Überprüfungen ermöglicht die kontinuierliche Überwachung eine Echtzeitanalyse, sodass Probleme erkannt werden, bevor sie eskalieren.

„KI-Systeme […] können mit Daten trainiert werden, die sich im Laufe der Zeit ändern können, manchmal erheblich und unerwartet, was sich auf schwer nachvollziehbare Weise auf die Funktionalität und Vertrauenswürdigkeit des Systems auswirkt.“

Um Datenabweichungen zu beheben, können fortschrittliche KI-SPM-Tools automatisch eingesetzte KI-Modelle erkennen, „Shadow AI“ identifizieren und sowohl Trainings- als auch Inferenz-Datensätze, einschließlich Dokumentenspeichern und Vektordatenbanken, abbilden. Diese Tools kennzeichnen auch Fehlkonfigurationen, wie beispielsweise öffentlich zugängliche Trainingsdaten, die Sicherheitsrisiken darstellen könnten.

Beispielsweise hat Net Solutions kürzlich mit einem nordamerikanischen Reinigungsunternehmen zusammengearbeitet, um KI-Governance für einen Vertriebs-Chat-Assistenten zu implementieren. Durch den Einsatz von Echtzeit-Überwachungstools wie AWS CloudWatch und DataDog sowie automatisierten Pipelines, die in Zoho Desk -Warnmeldungen integriert sind, gelang dem Unternehmen in nur sechs Wochen der Übergang von einem Proof-of-Concept zu einer konformen, skalierbaren KI-Lösung.

Der Technologe Akash Lomas von Net Solutions betont die Bedeutung der Überwachung:

„Messungen sind besonders wichtig in Umgebungen, in denen KI das Kundenerlebnis direkt beeinflusst. Ohne ständige Überwachung können diese Systeme fehlgeleitet werden und irrelevante, voreingenommene oder irreführende Inhalte liefern.“

Das Ignorieren von Datenabweichungen kann schwerwiegende Folgen haben: verminderte Systemleistung, Bußgelder und Vertrauensverlust. Darüber hinaus kosten Cyberangriffe Unternehmen durchschnittlich 4,45 Millionen Dollar pro Jahr.

8. Offenliegende sensible Trainingsdaten

Das Risiko, sensible Trainingsdaten offenzulegen, ist ein ernstes Problem, insbesondere wenn es um Verstöße gegen Compliance-Vorschriften geht. Laut NIST birgt generative KI zwölf verschiedene Risiken, wobei Datenschutzprobleme – wie die Weitergabe und unbefugte Offenlegung personenbezogener Daten – einen Schwerpunkt bilden. Viele Unternehmen stehen vor der Herausforderung, den Überblick darüber zu behalten, wo sich ihre KI-Trainingsdaten befinden, und deren Sicherheit zu gewährleisten.

Um dieses Problem anzugehen, sind AI-Security Posture Management (AI-SPM) -Tools unverzichtbar geworden. Diese Tools können automatisch eingesetzte KI-Modelle identifizieren und die für das Training verwendeten Datensätze über Cloud-Plattformen hinweg lokalisieren, einschließlich Dokumentenspeichern und Vektordatenbanken. Außerdem kennzeichnen sie Schwachstellen wie öffentlich zugängliche Trainingsdaten oder offene Anwendungsendpunkte. Mahesh Nawale, Product Marketing Manager bei Zscaler, betont die Bedeutung dieser Tools:

„Zscaler AI-SPM lokalisiert automatisch Datensätze, die für KI-Training und -Inferenz in Ihrer Cloud-Umgebung verwendet werden – einschließlich Daten, Dokumentenspeichern und Vektordatenbanken. Es kennzeichnet Fehlkonfigurationen wie öffentlich zugängliche Trainingsdaten und gibt Ihren Sicherheitsteams die erforderlichen Einblicke, um Untersuchungen durchzuführen, Abhilfemaßnahmen zu ergreifen und die Compliance nachzuweisen.“

KI-Tools gehen über die reine Identifizierung von Fehlkonfigurationen hinaus. Sie überwachen auch das Modellverhalten, um potenzielle Bedrohungen zu erkennen. So können sie beispielsweise Probleme wie Datenspeicherung, Modellinversion oder verdächtige Aktivitäten wie umfangreiche Daten-Downloads oder unbefugte Änderungen erkennen, die auf eine Datenexfiltration hindeuten könnten. Automatisierte Scan-Funktionen erhöhen die Sicherheit zusätzlich, indem sie sensible Informationen – wie biometrische, Gesundheits- oder Standortdaten – identifizieren, die nicht ordnungsgemäß anonymisiert wurden.

Das NIST hat außerdem „Dioptra“ entwickelt, eine Softwarelösung, die Unternehmen dabei hilft, KI-Modelle auf Cyberangriffe zu testen. Sie misst, wie sich Angriffe auf die Modellleistung auswirken, und identifiziert Szenarien, in denen Trainingsdaten gefährdet sein könnten.

Katerina Megas, Programmmanagerin beim NIST, hebt die wachsende Herausforderung hervor:

„KI birgt neue Risiken der Re-Identifizierung, nicht nur aufgrund ihrer Analysefähigkeit über unterschiedliche Datensätze hinweg, sondern auch aufgrund potenzieller Datenlecks aus dem Modelltraining.“

Angesichts der enormen Datenmengen, die beim Training großer Sprachmodelle verwendet werden, sind kontinuierliche automatisierte Tests nicht mehr optional, sondern eine Notwendigkeit, um sensible Informationen zu schützen.

9. Fehlende Techniken zur Verringerung von Verzerrungen

Wenn KI-Systemen geeignete Methoden zur Bekämpfung von Verzerrungen fehlen, besteht die Gefahr, dass sie unfaire Ergebnisse verstärken und erhebliche Compliance-Probleme verursachen. Laut NIST ist der Umgang mit schädlichen Verzerrungen eines der sieben entscheidenden Merkmale eines vertrauenswürdigen KI-Systems. Herkömmliche Risikomanagement-Frameworks sind für den Umgang mit KI-Verzerrungen nicht ausreichend, sodass spezielle Strategien zur Risikominderung unerlässlich sind. Während in den vorangegangenen Abschnitten die Erkennung von Verzerrungen behandelt wurde, erfordert deren wirksame Bekämpfung klare Kontrollen und kontinuierliche Weiterbildungsmaßnahmen. Die bloße Identifizierung von Verzerrungen reicht nicht aus – es sind langfristige Strategien erforderlich, um ihnen entgegenzuwirken.

KI-Tools spielen eine wichtige Rolle beim Aufspüren von Lücken in der Bias-Kontrolle. Sie weisen auf Probleme wie fehlende Fairness-Metriken (z. B. ungleiche Auswirkungsverhältnisse oder Unterschiede in der Falsch-Positiv-Rate), Systeme ohne Adversarial Testing oder KI-Red Teaming sowie Modelle ohne geplante Nachschulungen hin, wodurch diese anfällig für Datenabweichungen sind.

„Ohne angemessene Kontrollen können KI-Systeme ungerechte oder unerwünschte Folgen für Einzelpersonen und Gemeinschaften verstärken, aufrechterhalten oder verschärfen.“ – NIST AI RMF 1.0

Um diesen Herausforderungen zu begegnen, führen KI-Governance-Plattformen automatisierte Scans durch, um Compliance-Lücken auf der Grundlage der NIST AI RMF-Richtlinien aufzudecken. Sie stellen sicher, dass Unternehmen die erforderlichen Sicherheitsvorkehrungen getroffen haben, wie z. B. Inhaltsfilter, Protokolle zur Korrektur von Verzerrungen und andere Schutzmaßnahmen, die durch Standards wie NIST AI 600-1 vorgeschrieben sind. Diese Plattformen verfolgen auch die Datenherkunft, um sicherzustellen, dass Trainingsdatensätze frei von Problemen sind, die zu verzerrten Ergebnissen führen könnten. Darüber hinaus identifizieren AI-Security Posture Management (AI-SPM)-Tools alle eingesetzten KI-Modelle, einschließlich „Shadow AI”-Systemen, die möglicherweise Fairness-Tests vollständig umgangen haben.

Da KI-Systeme Milliarden von Entscheidungen treffen, können unentdeckte Verzerrungen das Vertrauen der Öffentlichkeit untergraben, die bürgerlichen Freiheiten beeinträchtigen und regulatorische Sanktionen nach sich ziehen. Bemerkenswert ist, dass seit 2023 weltweit ein Anstieg von 21,3 % bei Erwähnungen von KI-Gesetzgebung zu verzeichnen ist. Diese Risiken unterstreichen die dringende Notwendigkeit einer kontinuierlichen, automatisierten Überwachung, um Fairness und Rechenschaftspflicht zu gewährleisten.

10. Unzureichende KI-Klassifizierung von Anbietern

Wenn Unternehmen KI-Systeme von Drittanbietern nicht richtig kategorisieren, setzen sie sich Compliance-Risiken aus, die sie möglicherweise gar nicht kommen sehen. Das Problem? Die Risikokennzahlen von Anbietern stimmen oft nicht mit den internen Risikorahmenbedingungen eines Unternehmens überein. Wenn Anbieter falsch klassifiziert werden, ist es unmöglich, die richtigen Kontrollen anzuwenden oder festzustellen, ob ihre Einstufung als „risikoarm” tatsächlich der Risikotoleranz Ihres Unternehmens entspricht. Diese Diskrepanz unterstreicht den Bedarf an automatisierten Tools, die die Klassifizierung von Anbietern in Echtzeit überprüfen können.

Hier kommen KI-gestützte Tools ins Spiel, die den Prozess der Identifizierung von Klassifizierungslücken automatisieren. Durch das Scannen von Lieferantenverträgen und technischen Spezifikationen lokalisieren diese Tools falsch klassifizierte Systeme und kennzeichnen nicht bewertete KI-Komponenten von Drittanbietern, wie in den NIST AI RMF-Funktionen Govern 6.1 und Map 4.1 beschrieben. Sie erkennen auch Systeme, denen es an Transparenz hinsichtlich kritischer Elemente wie vortrainierten Modellen, Datenpipelines oder Entwicklungsprozessen mangelt.

„Risiken können sowohl von Daten, Software oder Hardware Dritter als auch von deren Verwendung ausgehen.“ – NIST AI RMF 1.0

Das NIST Cybersecurity Framework Profile for AI, das unter Mitwirkung von über 6.500 Mitwirkenden entwickelt wurde, betont die Bedeutung der Transparenz der Lieferkette. KI-gesteuerte Tools helfen dabei, indem sie Echtzeit-Bestände von Drittanbietersystemen verwalten und die KI-Lieferkette abbilden, um nicht klassifizierte oder nicht geprüfte Komponenten aufzudecken. Diese Tools decken Schwachstellen in Software, Hardware oder Datenquellen auf, die möglicherweise erst während der Bereitstellung sichtbar werden. Mit einer automatisierten Lieferantenklassifizierung können Unternehmen einen umfassenden Überblick über ihre KI-Risikolandschaft gewinnen, der den Richtlinien des NIST entspricht.

Ein weiterer Vorteil der Automatisierung ist die Möglichkeit, Lieferantenbewertungen anhand der Sensibilität der Daten zu priorisieren. Beispielsweise werden Systeme, die personenbezogene Daten verarbeiten oder direkt mit Benutzern interagieren, für eine genauere Prüfung markiert. Dieser Ansatz berücksichtigt, dass ein System, das in einem bestimmten Kontext als risikoarm eingestuft wird – beispielsweise bei der Verarbeitung physischer Sensordaten –, in einem anderen Kontext, beispielsweise bei der Verwaltung geschützter Gesundheitsdaten, ein hohes Risiko darstellen kann. Ohne diese automatisierte Überwachung laufen Unternehmen Gefahr, Ressourcen für risikoarme Systeme zu verschwenden, während wichtige KI-Tools nur unzureichend überwacht werden.

Wie ISMS Copilot diese Lücken identifiziert

ISMS Copilot verfolgt einen frameworkspezifischen Ansatz, um Lücken in der NIST 800-53-Konformität aufzuzeigen. Anstatt das Internet nach Antworten zu durchsuchen, nutzt es Retrieval-Augmented Generation (RAG), um gezielte Informationen aus einem sorgfältig kuratierten Datensatz abzurufen. Dieser Datensatz umfasst über 30 Frameworks wie NIST 800-53, ISO 27001, SOC 2 und DSGVO und bietet präzise und umsetzbare Anleitungen zur Behebung von Compliance-Lücken.

Das Tool vereinfacht die Lückenanalyse, indem es Kontrollen über mehrere Standards hinweg abbildet, auditorenfertige Dokumentationen erstellt und umfangreiche Berichte aufschlüsselt. Mit ISMS Copilot One können Benutzer Compliance-Dokumente – selbst solche mit mehr als 20 Seiten – zur automatisierten Analyse hochladen. Derzeit vertrauen mehr als 600 Berater bei der Einhaltung von Informationssicherheitsvorschriften auf dieses Tool. Hier ein kurzer Vergleich der speziellen Funktionen von ISMS Copilot mit denen allgemeiner KI-Tools:

| Merkmal | ISMS-Copilot | Allgemeine KI |

|---|---|---|

| Datensatz | Fokus auf die Einhaltung von Informationssicherheitsvorschriften | Breites, allgemeines Wissen |

| Genauigkeit | Liefert rahmenspezifische Leitlinien | Oft vage oder zu allgemein |

| Prüfungsbereitschaft | Erstellt prüfungsfertige Dokumentation | Nicht für formelle Audits geeignet |

| Datenschutz | SOC 2 Typ II-konform; kein Training mit Benutzerdaten | Kann Benutzereingaben für Schulungen verwenden |

| Dokumentenanalyse | Führt detaillierte Lückenanalysen für umfangreiche Berichte durch | Beschränkt auf grundlegende Textverarbeitung |

Um Kundendaten zu schützen, bietet ISMS Copilot spezielle Arbeitsbereiche, in denen Projekte isoliert und sicher aufbewahrt werden. Alle Daten werden in SOC 2 Typ II-konformen Datenspeichern mit End-to-End-Verschlüsselung gespeichert, wodurch sichergestellt wird, dass hochgeladene Dokumente oder Konversationen niemals zum Trainieren der KI-Modelle verwendet werden.

Für Organisationen, die sich mit NIST 800-53-Lückenanalysen befassen, bietet ISMS Copilot klare, umsetzbare Schritte zur Implementierung von Kontrollen und zur Erfüllung der FISMA-Anforderungen. Sie können die kostenlose Version unter chat.ismscopilot.com testen. Die kostenpflichtigen Tarife beginnen bei 20 US-Dollar pro Monat.

Schlussfolgerung

KI hat die NIST-Compliance von einem periodischen, reaktiven Prozess zu einem proaktiven Echtzeitsystem verändert. Durch die Analyse ganzer Datensätze kann KI potenzielle Probleme erkennen, bevor sie sich zu größeren Problemen entwickeln. Mit KI-gesteuerter Automatisierung können Unternehmen jederzeit für Audits bereit sein, indem sie die Sammlung von Nachweisen automatisieren und gleichzeitig mit den sich ändernden Compliance-Anforderungen Schritt halten.

Tools wie Policy-as-Code und Continuous Assurance ermöglichen die Automatisierung von NIST-Kontrollen, wodurch Probleme bereits früh im Entwicklungsprozess behoben werden können. KI-gestützte Tools können Anomalien in verschiedenen Umgebungen schnell erkennen und gewährleisten so eine zentralisierte Überwachung über mehrere Compliance-Frameworks hinweg. Diese Funktionen bilden den Kern der von ISMS Copilot angebotenen Lösungen.

ISMS Copilot sorgt durch seinen RAG-Ansatz (Rot-Gelb-Grün) für kontinuierliche Compliance und nutzt dabei einen kuratierten Datensatz, der Frameworks wie NIST 800-53, ISO 27001, SOC 2 und weitere umfasst. Zu seinen Funktionen gehören automatisierte Lückenanalysen, frameworkübergreifendes Mapping und auditfähige Dokumentation, wodurch sichergestellt wird, dass Unternehmen stets mit den sich weiterentwickelnden NIST-Standards konform bleiben.

Zusätzlich zu diesen Vorteilen unterstützt ISMS Copilot mehrere Frameworks, was für die komplexen Sicherheitsprogramme von heute unerlässlich ist. Unternehmen können diese KI-gestützten Compliance-Tools kostenlos unter chat.ismscopilot.com testen.

Häufig gestellte Fragen

Wie vereinfacht KI die Bestandsverwaltung von Vermögenswerten für die NIST-Konformität?

Die Führung eines präzisen und aktuellen Bestandsverzeichnisses ist ein wesentlicher Bestandteil des NIST Cybersecurity Framework (z. B. ID.AM-1) und der NIST 800-53-Kontrollen. KI vereinfacht diese Aufgabe, indem sie die Erkennung, Klassifizierung und Verfolgung von Hardware- und Software-Assets automatisiert. Anstelle von traditionellen, oft fehleranfälligen manuellen Methoden nutzt KI fortschrittliche Techniken wie maschinelles Lernen, um den Netzwerkverkehr, die Endpunktaktivitäten und Cloud-Protokolle zu analysieren. Dieser Ansatz stellt sicher, dass nicht identifizierte oder nicht autorisierte Assets erkannt, Unstimmigkeiten hervorgehoben und das Inventar kontinuierlich aktualisiert wird.

KI-gestützte Tools wie ISMS Copilot optimieren diesen Prozess durch die nahtlose Integration mit Scannern, CMDBs und Cloud-APIs. Sie können NIST-konforme Inventartabellen automatisch ausfüllen und wichtige Dokumente wie Asset-Berichte und Änderungsprotokolle erstellen. Dank seiner natürlichen Sprachschnittstelle können Benutzer mit ISMS Copilot ganz einfach Fragen stellen wie „Auf welchen Geräten fehlen Firmware-Updates?“ und erhalten sofort umsetzbare Erkenntnisse. Dies reduziert nicht nur den manuellen Arbeitsaufwand, sondern erhöht auch die Genauigkeit und sorgt dafür, dass Ihr Anlageninventar perfekt mit den NIST-Standards synchronisiert ist.

Wie hilft KI dabei, Vorurteile in KI-Systemen zu erkennen und zu reduzieren?

KI spielt eine wichtige Rolle beim Aufspüren und Beheben von Verzerrungen in KI-Systemen. Das NIST AI Risk Management Framework hebt Fairness neben Sicherheit, Transparenz und Datenschutz als eines der wichtigsten Prinzipien einer vertrauenswürdigen KI hervor. Mithilfe von KI-Tools können Unternehmen große Datensätze, Vorhersagen und Metadaten durchforsten, um Muster ungleicher Behandlung aufzudecken – wie beispielsweise höhere Fehlerquoten, von denen bestimmte Bevölkerungsgruppen überproportional betroffen sind. Diese Tools wenden auch statistische Fairness-Metriken an und bieten umsetzbare Erkenntnisse, um die identifizierten Probleme zu beheben.

KI-gesteuerte Assistenten wie ISMS Copilot gehen noch einen Schritt weiter, indem sie KI-Systeme aktiv auf die Einhaltung der NIST-Kontrollen überwachen. Sie können fehlende Dokumentationen aufspüren, ungetestete Datenquellen kennzeichnen oder Lücken in Bias-Testverfahren identifizieren. Durch maßgeschneiderte Vorlagen und Schritt-für-Schritt-Anleitungen verwandeln diese Tools die Compliance von einer statischen Checkliste in einen interaktiven Workflow. Dies erleichtert es Unternehmen, Vorurteile zu beseitigen und sicherzustellen, dass ihre KI-Systeme nicht nur konform, sondern auch fairer und zuverlässiger sind.

Wie kann KI dabei helfen, Datenschutzkontrollen gemäß NIST-Standards zu automatisieren?

KI vereinfacht die Bewertung von Datenschutzkontrollen, indem sie das NIST Privacy Framework und die Datenschutzkontrollen gemäß SP 800-53 analysiert. Anschließend passt sie diese Kontrollen an die Datenflüsse, Systeme und Richtlinien Ihres Unternehmens an. Durch das Scannen von Konfigurationsdateien, API-Protokollen und Dokumentationen erstellt sie eine Echtzeitkarte, die Kontrollen mit Assets verknüpft und Probleme wie fehlende Verschlüsselung oder veraltete Zugriffskontrollen automatisch aufzeigt.

ISMS Copilot, oft als „das ChatGPT der ISO 27001“ bezeichnet, bringt diese Funktionalität in die NIST-Standards ein. Sie können es beispielsweise bitten, eine bestimmte Kontrolle zu bewerten, wie z. B. NIST 800-53 Privacy Control AU-3. Als Antwort darauf generiert es maßgeschneiderte Checklisten, Schritte zum Sammeln von Beweisen und Abhilfemaßnahmen. Dies eliminiert mühsame manuelle Arbeit und bietet sofortige, präzise und umsetzbare Erkenntnisse zur Optimierung der Compliance-Bemühungen.