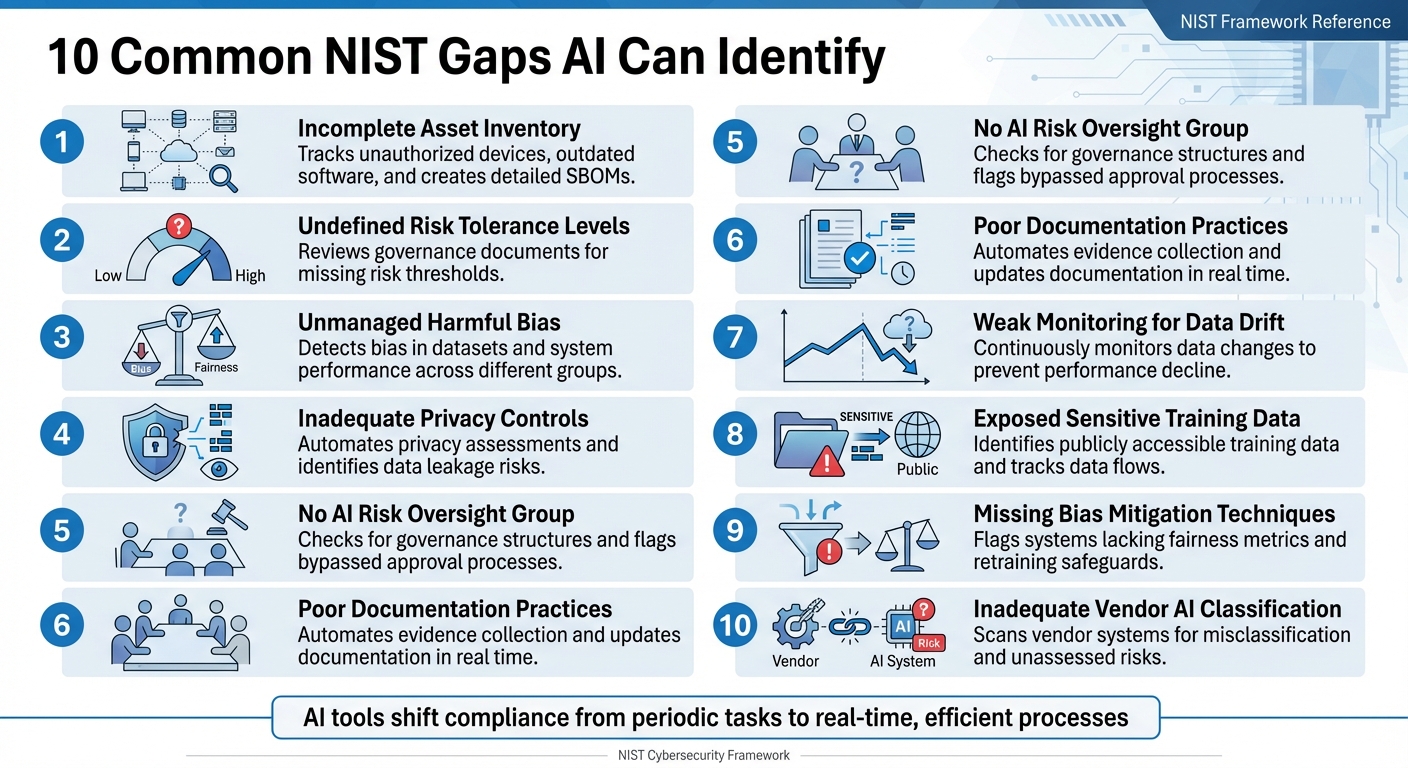

Las organizaciones suelen tener dificultades para cumplir plenamente el Marco de Ciberseguridad (CSF) del NIST, especialmente con su última versión, CSF 2.0. Las auditorías manuales son lentas y propensas a errores, lo que deja lagunas en áreas como el seguimiento de activos, la gestión de riesgos y los controles de privacidad. Las herramientas basadas en la inteligencia artificial cambian las reglas del juego al automatizar las comprobaciones de cumplimiento, proporcionar una supervisión continua e identificar las lagunas en tiempo real. A continuación se enumeran diez lagunas comunes en el cumplimiento del NIST que la inteligencia artificial puede subsanar:

- Inventario de activos incompleto: la IA rastrea dispositivos no autorizados y software obsoleto, y crea listas detalladas de materiales de software (SBOM).

- Niveles de tolerancia al riesgo indefinidos: la IA revisa los documentos de gobernanza en busca de umbrales de riesgo que falten.

- Sesgo no gestionado: la IA detecta sesgos en los conjuntos de datos y en el rendimiento del sistema entre diferentes grupos.

- Controles de privacidad inadecuados: la IA automatiza las evaluaciones de privacidad e identifica riesgos como la fuga de datos.

- Sin grupo de supervisión de riesgos de IA: la IA comprueba las estructuras de gobernanza y señala los procesos de aprobación que se han eludido.

- Prácticas deficientes de documentación: la IA automatiza la recopilación de pruebas y actualiza la documentación en tiempo real.

- Supervisión deficiente de la deriva de datos: las herramientas de IA supervisan continuamente los cambios en los datos para evitar la disminución del rendimiento.

- Datos de entrenamiento sensibles expuestos: la IA identifica riesgos como los datos de entrenamiento accesibles públicamente y realiza un seguimiento de los flujos de datos.

- Técnicas de mitigación de sesgos ausentes: la IA señala los sistemas que carecen de métricas de equidad y salvaguardias de reciclaje.

- Clasificación inadecuada de proveedores por parte de la IA: la IA analiza los sistemas de los proveedores en busca de clasificaciones erróneas y riesgos no evaluados.

Las herramientas de IA como ISMS Copilot agilizan el cumplimiento normativo al automatizar el análisis de deficiencias, alinear los controles con los estándares del NIST y generar documentación lista para auditorías. Esto transforma el cumplimiento normativo de una tarea periódica a un proceso eficiente en tiempo real.

10 deficiencias comunes en el cumplimiento de las normas del NIST que la IA puede identificar y solucionar

GRC - Análisis de deficiencias 101 utilizando el cumplimiento de los controles NIST RMF y CIS

1. Inventario de activos incompleto

Contar con un inventario exhaustivo de activos es fundamental para cumplir con los requisitos de conformidad del NIST. Sin embargo, muchas organizaciones tienen dificultades para realizar un seguimiento de todos los dispositivos, aplicaciones y componentes de software que utilizan. Cuando los activos no se controlan, se crean vulnerabilidades que los atacantes pueden aprovechar.

Un copiloto NIST 800-53 puede ayudarle comparando el estado real de su red con el estado deseado. El escaneo continuo destaca cualquier desviación de su lista de activos aprobados, lo que facilita la detección de problemas como dispositivos no autorizados o software obsoleto que carece de parches de seguridad críticos. Este proceso continuo no solo refuerza la gestión de riesgos, sino que también proporciona información valiosa sobre la seguridad de su red.

«El objetivo principal de la capacidad SWAM es gestionar el riesgo creado por el software no gestionado o no autorizado en una red. El software no gestionado o no autorizado es un objetivo que los atacantes pueden utilizar como plataforma desde la que atacar componentes de la red». – NIST IR 8011 Vol. 3

Más allá del escaneo, los paneles de control de CDM ofrecen visibilidad en tiempo real de su inventario de activos, alejándose de las auditorías estáticas y obsoletas para pasar a una supervisión continua. Los sistemas de IA también pueden crear automáticamente una lista detallada de materiales de software (SBOM) para cada compilación de software, catalogando todos los componentes y dependencias, ya sean directas o indirectas. Esta funcionalidad es cada vez más importante, ya que casi 220 000 organizaciones estadounidenses deben cumplir con las normas CMMC, y 80 000 de ellas están sujetas a controles de nivel 2 que se ajustan a la norma NIST SP 800-171.

Para mejorar el inventario de activos, considere la posibilidad de utilizar etiquetas de identificación de software (SWID) para automatizar la detección de software en toda la red. También puede implementar listas blancas automatizadas para garantizar que solo se permita ejecutar el software autorizado. En el caso de los sistemas de IA, es esencial hacer un inventario no solo del hardware, sino también de las integraciones de terceros de las que dependen, ya que estos componentes externos pueden introducir riesgos adicionales.

2. Niveles de tolerancia al riesgo indefinidos

Muchas organizaciones reconocen los riesgos asociados a la IA, pero a menudo no establecen umbrales claros sobre lo que es aceptable. Sin estos límites definidos, a los equipos les puede resultar difícil determinar cuándo seguir adelante o detener un proyecto. Aquí es donde las herramientas de IA resultan útiles. Mediante el procesamiento del lenguaje natural, los asistentes ISMS entre marcos pueden revisar las políticas, las estrategias de gestión de riesgos y los marcos de gobernanza para confirmar si se han establecido criterios específicos, como límites cuantitativos o cualitativos, para diferentes aplicaciones de IA. Por ejemplo, los sistemas que manejan datos sensibles, como la información de identificación personal (PII), requieren umbrales más estrictos para garantizar la seguridad y el cumplimiento. Cuando faltan estas salvaguardias, es necesario tomar medidas correctivas inmediatas, tal y como destaca el NIST.

«En la medida en que sigan sin resolverse los retos que plantea la especificación de los niveles de tolerancia al riesgo de la IA, puede haber contextos en los que aún no sea posible aplicar fácilmente un marco de gestión de riesgos para mitigar los riesgos negativos de la IA». - NIST AI RMF 1.0

El NIST define la tolerancia al riesgo como «la disposición de la organización o del actor de IA a asumir el riesgo para alcanzar sus objetivos». Las herramientas de IA desempeñan un papel crucial en el análisis de los documentos de gobernanza para comprobar si existen criterios de aceptación de riesgos claramente documentados, ya sea en forma de límites numéricos o de límites cualitativos más amplios. Sin embargo, el Marco de Gestión de Riesgos de IA del NIST, presentado el 26 de enero de 2023, no establece niveles de tolerancia específicos. En su lugar, destaca la importancia de identificar las deficiencias —como la falta de documentación sobre los riesgos residuales o las estrategias de gestión de riesgos vagas— que podrían dejar a las organizaciones expuestas.

El NIST ofrece una directriz clara para este tipo de situaciones:

«En los casos en que un sistema de IA presente niveles de riesgo negativos inaceptables... se deberá suspender su desarrollo y despliegue de forma segura hasta que los riesgos puedan gestionarse adecuadamente». - NIST AI RMF 1.0

3. Sesgos perjudiciales no gestionados

El sesgo en los sistemas de IA se deriva de la interacción entre el código, los datos de entrenamiento y el contexto social más amplio. Sin unas políticas de cumplimiento adecuadas, estos sistemas pueden agravar involuntariamente las desigualdades existentes o incluso crear nuevos patrones de discriminación. Esto tiene consecuencias reales en ámbitos como la sanidad, la contratación y las finanzas. El problema se ve agravado por la complejidad de los sistemas de IA, que a menudo implican innumerables puntos de decisión, lo que hace casi imposible identificar y abordar manualmente los sesgos. Las organizaciones suelen recurrir a un asistente de cumplimiento de IA para gestionar estos flujos de trabajo complejos y de múltiples pasos.

«Sin los controles adecuados, los sistemas de IA pueden amplificar, perpetuar o exacerbar resultados injustos o indeseables para las personas y las comunidades». - NIST AI RMF 1.0

Las herramientas de IA abordan los sesgos perjudiciales mediante procesos como la prueba, la evaluación, la verificación y la validación (TEVV), tal y como se describe en la función MEASURE del NIST AI RMF. Estos procesos evalúan si los conjuntos de datos de entrenamiento se ajustan a su finalidad prevista y reflejan las condiciones sociales actuales. La supervisión automatizada desempeña aquí un papel fundamental, ya que identifica la «deriva de datos», es decir, los cambios en los datos de entrada que pueden afectar al rendimiento del sistema e introducir nuevos sesgos que quizá no estuvieran presentes durante las pruebas iniciales.

Este proceso de detección va más allá del simple cálculo de cifras. Las herramientas de IA evalúan el rendimiento de los sistemas en diversos subgrupos, reconociendo que incluso las personas que no utilizan directamente el sistema pueden verse afectadas. Este enfoque, a menudo denominado evaluación sociotécnica, tiene en cuenta no solo el diseño técnico, sino también cómo interactúa con las normas sociales y el comportamiento humano para generar desigualdades. Para garantizar la objetividad, el NIST aboga por una clara división de responsabilidades: los equipos que crean modelos de IA deben estar separados de los que los verifican y validan. Esta configuración permite realizar evaluaciones más imparciales y un seguimiento continuo de los sesgos en todos los grupos de usuarios.

Otra estrategia clave para gestionar los sesgos es mejorar el seguimiento de los datos. Por ejemplo, las organizaciones que utilizan herramientas de visibilidad nativas de IA informaron de un asombroso aumento del 1660 % en su capacidad para supervisar las actividades de procesamiento de datos en tan solo tres semanas desde su implementación. Estas herramientas trazan «recorridos de datos», siguiendo el flujo de los datos desde su origen a través de los modelos de IA. De este modo, pueden predecir y prevenir posibles infracciones en tiempo real. Esto es fundamental, ya que la IA procesa los datos a velocidades muy superiores a las que pueden manejar los equipos manuales. El seguimiento de estos flujos de datos es esencial para detectar cambios que puedan dar lugar a sesgos nuevos o agravar los ya existentes antes de que causen daños.

4. Controles de privacidad inadecuados

El rápido ritmo y la magnitud de los sistemas de IA hacen que las brechas de privacidad sean una preocupación importante, especialmente porque la supervisión manual tiene dificultades para mantenerse al día. Sin las garantías de privacidad adecuadas, las organizaciones corren el riesgo de exponer información de identificación personal (PII) a través de fugas de datos de entrenamiento, accesos no autorizados o divulgaciones no intencionadas en los resultados de los modelos. La dependencia de las API para la ingesta de datos y la inferencia aumenta aún más la superficie de ataque, lo que hace que sea necesario contar con controles de privacidad robustos.

Para hacer frente a estos retos, las herramientas de IA, incluidos los asistentes especializados en cumplimiento normativo, ahora automatizan las evaluaciones de control de la privacidad utilizando formatos legibles por máquina como OSCAL. Estas herramientas evalúan continuamente los controles descritos en marcos como NIST SP 800-53, utilizando formatos como JSON, XML y YAML. Cabe destacar que, el 27 de agosto de 2025, el NIST publicó la versión 5.2.0 de SP 800-53, que integraba completamente los controles de privacidad en el catálogo más amplio de controles de seguridad, alejándose del enfoque independiente anterior.

«Abordar la funcionalidad y la garantía ayuda a garantizar que los productos de tecnología de la información y los sistemas que dependen de ellos sean suficientemente fiables». - Grupo de trabajo conjunto, NIST SP 800-53 Rev. 5

Las herramientas automatizadas se centran en la familia de controles de procesamiento y transparencia de la información de identificación personal (PII) para identificar el uso no autorizado de la PII, las divulgaciones o los riesgos de desanonimización. También descubren las API ocultas y la IA oculta que las auditorías manuales suelen pasar por alto. Al implementar «Policy-as-Code», las organizaciones pueden convertir los complejos requisitos de NIST SP 800-53 en reglas operativas en tiempo real. Este proceso se agiliza cuando las organizaciones forman a sus asistentes de cumplimiento de IA en modelos de alta precisión diseñados para GRC. Estas reglas ocultan automáticamente los datos confidenciales de las indicaciones y los resultados de la IA antes de que sean procesados por el modelo.

Además, el software Dioptra del NIST admite ejercicios de red teaming, lo que ayuda a las organizaciones a probar los controles de privacidad y seguridad en condiciones adversas. Estas simulaciones pueden medir las pérdidas de rendimiento e identificar vulnerabilidades específicas. Esto es especialmente importante dado que el perfil de IA generativa del NIST AI RMF describe 12 riesgos únicos o elevados asociados con la IA, incluidas preocupaciones sobre la privacidad de los datos, como la fuga y la desanonimización no autorizada. El 14 de abril de 2025, el NIST volvió a hacer hincapié en estas cuestiones con la publicación del borrador del Marco de Privacidad 1.1, que aborda específicamente los riesgos de privacidad relacionados con la IA, como los ataques de inferencia y la amplificación de sesgos.

5. No hay grupo de supervisión de riesgos de IA.

Uno de los principales retos de la gestión de riesgos de la IA es la ausencia de un grupo de supervisión específico. Sin dicho comité, la gobernanza y la rendición de cuentas suelen quedar en segundo plano, lo que da lugar a iniciativas fragmentadas y de menor prioridad. Hoy en día, las herramientas avanzadas que aprovechan el procesamiento del lenguaje natural (NLP) pueden ayudar a subsanar esta deficiencia mediante el análisis de las políticas, los estatutos y las actas de las reuniones de la organización. Estas herramientas pueden confirmar si existe un grupo formal de supervisión de riesgos de la IA y garantizar la alineación con la función «Gobernar» del NIST AI RMF, concretamente con Govern 1.2, que hace hincapié en la necesidad de estructuras claras de gobernanza y rendición de cuentas.

Los sistemas basados en IA también examinan los organigramas y los sistemas de gestión de identidades para identificar las funciones de supervisión formales dentro de la gestión de riesgos de la IA. Las plataformas de gobernanza añaden otra capa de protección al señalar los proyectos que eluden los procesos de aprobación formales. Esto garantiza una supervisión continua, un componente fundamental para cumplir con el RMF del NIST. La función «Gobernar» actúa como base, influyendo en todas las demás funciones del RMF, como «Mapear», «Medir» y «Gestionar». Este enfoque interconectado refuerza el marco general.

«Sin una responsabilidad definida, los esfuerzos de gestión de riesgos de la IA pueden fragmentarse o perder prioridad, dejando a la organización expuesta». - Kezia Farnham, directora sénior, Diligent

La urgencia de una supervisión adecuada se ve subrayada por el rápido crecimiento de la inversión y la regulación en materia de IA. En 2024, la inversión del sector privado estadounidense en IA superó los 100 000 millones de dólares, mientras que las menciones a la IA en la legislación mundial aumentaron un 21,3 % en 75 países desde 2023, lo que supone un asombroso aumento de nueve veces desde 2016. Sin mecanismos de supervisión formales, las organizaciones corren el riesgo de incumplir las normativas emergentes, como la Ley de IA de la UE y la Orden Ejecutiva 14110 de EE. UU., que destacan la importancia de la supervisión humana y la gestión de riesgos auditable.

Para salvar esta brecha, las organizaciones deben crear un comité multifuncional de riesgos de IA que incluya a líderes clave como el director jurídico, el director de seguridad de la información (CISO), el director de riesgos y los responsables de IA/ML. Asignar la responsabilidad del RMF de IA a un único ejecutivo, a menudo el director de riesgos o el director jurídico, puede centralizar aún más la rendición de cuentas. Además, la adopción de un asistente de cumplimiento de IA diseñado específicamente para este fin puede agilizar este proceso, automatizando la asignación de funciones y responsabilidades y sustituyendo las hojas de cálculo manuales obsoletas por sistemas de supervisión continua.

6. Prácticas deficientes en materia de documentación

A partir de problemas anteriores con el seguimiento y la supervisión de activos, la documentación deficiente socava aún más los esfuerzos de cumplimiento. Las lagunas en la documentación son generalizadas y costosas cuando se trata del cumplimiento de las normas del NIST. Un sorprendente 86 % de las organizaciones carece de visibilidad sobre sus flujos de datos de IA, lo que da lugar a importantes lagunas en la documentación y la auditoría que pueden suponer un problema durante las revisiones normativas. Por ejemplo, cuando los auditores solicitan registros de interacciones de IA que implican datos personales, muchas organizaciones no pueden proporcionarlos. Este incumplimiento viola normativas clave como el artículo 30 del RGPD, la sección 1798.130 de la CCPA y la sección 164.312 de la HIPAA.

Las plataformas de cumplimiento normativo basadas en inteligencia artificial ofrecen una solución práctica al sustituir las obsoletas hojas de cálculo manuales por paneles de control en tiempo real. Estos paneles de control señalan automáticamente la falta de pruebas y los problemas de documentación. También utilizan un control continuo para detectar «desviaciones», es decir, casos en los que la documentación o las políticas actuales ya no se ajustan al estado real de los sistemas o la infraestructura. Las herramientas automatizadas capturan configuraciones y registros en tiempo real, creando pistas de auditoría completas.

«Tratar cada cambio, implementación e incidente como un evento de documentación garantiza una acumulación constante de pruebas que es mucho más fiable que un esfuerzo apresurado tras el incidente». - Abnormal AI

El principio de «documentar sobre la marcha» refuerza el cumplimiento normativo al recopilar pruebas en tiempo real. Al integrarse con herramientas como wikis con control de versiones y sistemas de tickets, la IA garantiza que las aprobaciones y las capturas de pantalla se adjunten a las solicitudes de extracción. Esto es especialmente importante si se tiene en cuenta que solo el 17 % de las organizaciones han implementado controles de seguridad automatizados basados en IA capaces de proporcionar los registros necesarios para las auditorías normativas.

Las organizaciones que aprovechan las plataformas de cumplimiento automatizadas obtienen importantes beneficios, entre los que se incluyen la reducción de los ciclos de revisión de semanas a meras horas y la disminución significativa de las cargas de trabajo relacionadas con el cumplimiento. Estas herramientas también comparan el «perfil actual» de una organización con el «perfil objetivo» del NIST, identificando las deficiencias en las medidas de seguridad y la documentación. Al automatizar el proceso de «identificar, evaluar y categorizar», ayudan a garantizar que los inventarios de activos y las clasificaciones de riesgos se mantengan actualizados. Este enfoque continuo de la documentación desempeña un papel fundamental en el mantenimiento del cumplimiento del NIST.

sbb-itb-4566332

7. Supervisión deficiente de la deriva de datos

La deriva de datos se produce cuando los datos con los que se entrenó un sistema de IA cambian con el tiempo, lo que provoca una disminución del rendimiento y la fiabilidad. Dado que más del 75 % de las organizaciones utilizan actualmente la IA en al menos una función empresarial, no supervisar estos cambios supone un grave riesgo de incumplimiento normativo, un riesgo que las herramientas basadas en IA están perfectamente equipadas para abordar. Para hacer frente a este problema se necesitan soluciones de supervisión más avanzadas, como se describe a continuación.

En la práctica, la IA suele funcionar como una «caja negra», lo que dificulta la detección de problemas. El 45 % de las organizaciones citan la preocupación por la precisión o el sesgo de los datos como un obstáculo importante para la adopción de la IA. Sin embargo, muchas aún carecen de las herramientas necesarias para la supervisión continua, lo que las hace vulnerables a la deriva de datos. A diferencia de las comprobaciones manuales, la supervisión continua permite realizar análisis en tiempo real y detectar los problemas antes de que se agraven.

«Los sistemas de IA... pueden entrenarse con datos que pueden cambiar con el tiempo, a veces de forma significativa e inesperada, lo que afecta a la funcionalidad y la fiabilidad del sistema de maneras que son difíciles de comprender».

Para abordar la deriva de datos, las herramientas avanzadas de AI-SPM pueden detectar automáticamente los modelos de IA implementados, identificar la «IA en la sombra» y mapear los conjuntos de datos de entrenamiento e inferencia, incluidos los almacenes de documentos y las bases de datos vectoriales. Estas herramientas también señalan las configuraciones incorrectas, como los datos de entrenamiento accesibles al público, que podrían suponer riesgos para la seguridad.

Por ejemplo, Net Solutions ha colaborado recientemente con una empresa norteamericana de limpieza comercial para implementar la gobernanza de la IA en un asistente de chat de ventas. Mediante el uso de herramientas de supervisión en tiempo real como AWS CloudWatch y DataDog, junto con canalizaciones automatizadas integradas con alertas de Zoho Desk, la empresa pasó de una prueba de concepto a una solución de IA escalable y conforme con la normativa en solo seis semanas.

El tecnólogo Akash Lomas, de Net Solutions, destaca la importancia de la supervisión:

«La medición cobra especial importancia en entornos en los que la IA moldea directamente la experiencia del cliente... Sin una supervisión continua, estos sistemas pueden desviarse y ofrecer contenidos irrelevantes, sesgados o engañosos».

Ignorar la deriva de datos puede acarrear graves consecuencias: reducción del rendimiento del sistema, multas reglamentarias y pérdida de confianza. Además, los ciberataques cuestan a las empresas una media de 4,45 millones de dólares al año.

8. Datos de formación confidenciales expuestos

El riesgo de exponer datos confidenciales de entrenamiento es una preocupación grave, especialmente cuando se trata de infracciones de cumplimiento normativo. Según el NIST, la IA generativa introduce 12 riesgos distintos, entre los que destacan los problemas de privacidad de los datos, como la filtración y la divulgación no autorizada de información personal. Muchas organizaciones se enfrentan al reto de realizar un seguimiento de la ubicación de sus datos de entrenamiento de IA y garantizar su seguridad.

Para hacer frente a esto, las herramientas de gestión de la postura de seguridad de la IA (AI-SPM) se han vuelto esenciales. Estas herramientas pueden identificar automáticamente los modelos de IA implementados y localizar los conjuntos de datos utilizados para el entrenamiento en todas las plataformas en la nube, incluyendo el almacenamiento de documentos y las bases de datos vectoriales. También señalan vulnerabilidades, como los datos de entrenamiento accesibles al público o los puntos finales de aplicaciones abiertas. Mahesh Nawale, director de marketing de productos de Zscaler, destaca la importancia de estas herramientas:

«Zscaler AI-SPM localiza automáticamente los conjuntos de datos utilizados en el entrenamiento y la inferencia de IA en todo su entorno de nube, incluidos datos, almacenes de documentos y bases de datos vectoriales. Señala configuraciones incorrectas, como datos de entrenamiento accesibles públicamente, lo que proporciona a sus equipos de seguridad la información necesaria para investigar, corregir y demostrar el cumplimiento».

Las herramientas de IA van más allá de la simple identificación de configuraciones erróneas. También supervisan el comportamiento de los modelos para detectar posibles amenazas. Por ejemplo, pueden detectar problemas como la memorización de datos, la inversión de modelos o actividades sospechosas, como descargas de grandes volúmenes de datos o cambios no autorizados, que podrían indicar una filtración de datos. Las funciones de análisis automatizado refuerzan aún más la seguridad al identificar información confidencial, como datos biométricos, de salud o de ubicación, que no se ha anonimizado adecuadamente.

El NIST también ha desarrollado «Dioptra», una solución de software que ayuda a las organizaciones a probar los modelos de IA frente a los ciberataques. Mide cómo afectan los ataques al rendimiento de los modelos e identifica situaciones en las que los datos de entrenamiento podrían estar en peligro.

Katerina Megas, directora de programas del NIST, destaca el creciente desafío:

«La IA crea nuevos riesgos de reidentificación, no solo por su capacidad analítica en conjuntos de datos dispares, sino también por la posible filtración de datos durante el entrenamiento de los modelos».

Con los enormes conjuntos de datos que se utilizan en el entrenamiento de los grandes modelos lingüísticos, las pruebas automatizadas continuas ya no son opcionales, sino una necesidad para proteger la información confidencial.

9. Técnicas de mitigación del sesgo ausentes

Cuando los sistemas de IA carecen de métodos adecuados para abordar los sesgos, corren el riesgo de amplificar los resultados injustos y crear importantes problemas de cumplimiento. Según el NIST, la gestión de los sesgos perjudiciales es una de las siete características fundamentales de un sistema de IA fiable. Los marcos tradicionales de gestión de riesgos se quedan cortos a la hora de abordar los sesgos de la IA, por lo que es esencial contar con estrategias de mitigación especializadas. Si bien en las secciones anteriores se ha tratado la detección de sesgos, para abordarlos de forma eficaz se requieren controles claros y esfuerzos continuos de recapacitación. No basta con identificar los sesgos, sino que se necesitan estrategias a largo plazo para contrarrestarlos.

Las herramientas de IA desempeñan un papel fundamental a la hora de detectar deficiencias en los controles de sesgo. Señalan problemas como la falta de métricas de equidad (por ejemplo, ratios de impacto desigual o diferencias en la tasa de falsos positivos), sistemas que carecen de pruebas adversarias o equipos rojos de IA, y modelos sin reentrenamiento programado, lo que los hace vulnerables a la deriva de datos.

«Sin los controles adecuados, los sistemas de IA pueden amplificar, perpetuar o exacerbar resultados injustos o indeseables para las personas y las comunidades». – NIST AI RMF 1.0

Para hacer frente a estos retos, las plataformas de gobernanza de la IA realizan análisis automatizados para detectar deficiencias de cumplimiento basadas en las directrices del NIST AI RMF. Se aseguran de que las organizaciones hayan implementado las medidas de seguridad necesarias, como filtros de contenido, protocolos de corrección de sesgos y otras medidas de protección exigidas por normas como la NIST AI 600-1. Estas plataformas también rastrean el linaje de los datos para confirmar que los conjuntos de datos de entrenamiento están libres de problemas que puedan dar lugar a resultados sesgados. Además, las herramientas de gestión de la postura de seguridad de la IA (AI-SPM) identifican todos los modelos de IA implementados, incluidos los sistemas de «IA en la sombra» que pueden haber eludido por completo las pruebas de equidad.

Dado que los sistemas de IA toman miles de millones de decisiones, los sesgos no detectados pueden erosionar la confianza pública, infringir las libertades civiles y dar lugar a sanciones normativas. Cabe destacar que, desde 2023, se ha producido un aumento global del 21,3 % en las menciones a la legislación sobre IA. Estos riesgos ponen de relieve la urgente necesidad de una supervisión continua y automatizada para garantizar la equidad y la rendición de cuentas.

10. Clasificación inadecuada de la IA de los proveedores

Cuando las organizaciones no clasifican adecuadamente los sistemas de IA de terceros, se exponen a riesgos de cumplimiento que tal vez ni siquiera prevean. ¿Cuál es el problema? Las métricas de riesgo de los proveedores a menudo no se ajustan a los marcos de riesgo internos de las empresas. Si los proveedores se clasifican erróneamente, es imposible aplicar los controles adecuados o determinar si su etiqueta de «bajo riesgo» se ajusta realmente a la tolerancia al riesgo de su organización. Este desajuste pone de relieve la necesidad de herramientas automatizadas que puedan verificar las clasificaciones de los proveedores en tiempo real.

Aquí es donde entran en juego las herramientas basadas en IA, que automatizan el proceso de identificación de las deficiencias en la clasificación. Al escanear los contratos de los proveedores y las especificaciones técnicas, estas herramientas detectan los sistemas mal clasificados y señalan los componentes de IA de terceros no evaluados, tal y como se describe en las funciones Govern 6.1 y Map 4.1 del NIST AI RMF. También detectan los sistemas que carecen de transparencia en elementos críticos como los modelos preentrenados, los flujos de datos o los procesos de desarrollo.

«El riesgo puede surgir tanto de los datos, el software o el hardware de terceros como de la forma en que se utilizan». – NIST AI RMF 1.0

El perfil del marco de ciberseguridad del NIST para la IA, desarrollado con la colaboración de más de 6500 contribuyentes, destaca la importancia de la visibilidad de la cadena de suministro. Las herramientas basadas en IA ayudan a mantener inventarios en tiempo real de sistemas de terceros, mapeando la cadena de suministro de IA para descubrir componentes no clasificados o no verificados. Estas herramientas exponen vulnerabilidades ocultas en el software, el hardware o las fuentes de datos que solo podrían hacerse evidentes durante la implementación. Con la clasificación automatizada de proveedores, las organizaciones pueden obtener una visión completa de su panorama de riesgos de IA, en línea con las directrices del NIST.

Otra ventaja de la automatización es su capacidad para priorizar las evaluaciones de los proveedores en función de la sensibilidad de los datos. Por ejemplo, los sistemas que manejan información de identificación personal o interactúan directamente con los usuarios se marcan para un examen más detallado. Este enfoque reconoce que un sistema considerado de bajo riesgo en un contexto, como el procesamiento de datos de sensores físicos, puede suponer un alto riesgo en otro, como la gestión de información sanitaria protegida. Sin esta supervisión automatizada, las empresas corren el riesgo de malgastar recursos en sistemas de bajo riesgo, mientras que las herramientas de IA de alto riesgo quedan sin la supervisión adecuada.

Cómo identifica ISMS Copilot estas deficiencias

ISMS Copilot adopta un enfoque específico para cada marco con el fin de identificar las deficiencias en el cumplimiento de la norma NIST 800-53. En lugar de buscar respuestas en Internet, utiliza la generación aumentada por recuperación (RAG) para extraer información específica de un conjunto de datos cuidadosamente seleccionado. Este conjunto de datos incluye más de 30 marcos como NIST 800-53, ISO 27001, SOC 2 y GDPR, lo que proporciona una orientación precisa y práctica para abordar las deficiencias de cumplimiento.

La herramienta simplifica el análisis de deficiencias al mapear los controles en múltiples estándares, crear documentación lista para los auditores y desglosar informes extensos. Con ISMS Copilot One, los usuarios pueden cargar documentos de cumplimiento, incluso aquellos que superan las 20 páginas, para su análisis automatizado. Actualmente, más de 600 consultores confían en esta herramienta para sus necesidades de cumplimiento de la seguridad de la información. A continuación, se muestra una comparación rápida de las características especializadas de ISMS Copilot frente a las herramientas de IA de uso general:

| Característica | Copiloto ISMS | IA de propósito general |

|---|---|---|

| Conjunto de datos | Centrado en el cumplimiento de la seguridad de la información | Amplia base de conocimientos generales |

| Precisión | Proporciona orientación específica para cada marco. | A menudo impreciso o demasiado genérico. |

| Preparación para la auditoría | Crea documentación lista para el auditor. | No está diseñado para auditorías formales. |

| Privacidad de los datos | Cumple con SOC 2 Tipo II; sin entrenamiento de datos de usuario. | Puede utilizar las entradas del usuario para el entrenamiento. |

| Análisis de documentos | Realiza análisis detallados de deficiencias para informes extensos. | Limitado al procesamiento básico de texto. |

Para proteger la información de los clientes, ISMS Copilot ofrece espacios de trabajo dedicados que mantienen los proyectos aislados y seguros. Todos los datos se almacenan en almacenes de datos que cumplen con la norma SOC 2 Tipo II y cuentan con cifrado de extremo a extremo, lo que garantiza que los documentos o conversaciones cargados nunca se utilicen para entrenar sus modelos de IA.

Para las organizaciones que se enfrentan a análisis de deficiencias según la norma NIST 800-53, ISMS Copilot ofrece pasos claros y prácticos para implementar controles y cumplir los requisitos de la FISMA. Puede explorar la versión gratuita en chat.ismscopilot.com, con planes de pago a partir de 20 $ al mes.

Conclusión

La IA ha transformado el cumplimiento de las normas del NIST, pasando de ser un proceso periódico y reactivo a un sistema proactivo y en tiempo real. Mediante el análisis de conjuntos de datos completos, la IA puede identificar posibles problemas antes de que se conviertan en problemas mayores. Con la automatización impulsada por la IA, las organizaciones pueden estar preparadas para las auditorías automatizando la recopilación de pruebas y manteniéndose al día con los cambiantes requisitos de cumplimiento.

Herramientas como «policy-as-code» (política como código) y «continuous assurance» (garantía continua) permiten automatizar los controles del NIST, abordando los problemas en una fase temprana del proceso de desarrollo. Las herramientas basadas en inteligencia artificial pueden detectar rápidamente anomalías en diversos entornos, lo que garantiza una supervisión centralizada en múltiples marcos de cumplimiento. Estas capacidades son el núcleo de las soluciones que ofrece ISMS Copilot.

ISMS Copilot garantiza el cumplimiento continuo mediante su enfoque RAG (rojo-ámbar-verde), aprovechando un conjunto de datos seleccionados que abarca marcos como NIST 800-53, ISO 27001, SOC 2 y otros. Entre sus características se incluyen el análisis automatizado de deficiencias, la correspondencia entre marcos y la documentación lista para auditorías, lo que garantiza que las organizaciones se mantengan alineadas con los estándares NIST en constante evolución.

Además de estas ventajas, ISMS Copilot es compatible con múltiples marcos, algo fundamental para los complejos programas de seguridad actuales. Las organizaciones pueden explorar estas herramientas de cumplimiento normativo basadas en inteligencia artificial de forma gratuita en chat.ismscopilot.com.

Preguntas frecuentes

¿Cómo simplifica la IA la gestión del inventario de activos para el cumplimiento de las normas del NIST?

Mantener un inventario de activos preciso y actualizado es un componente fundamental del Marco de Ciberseguridad del NIST (por ejemplo, ID.AM-1) y de los controles NIST 800-53. La IA simplifica esta tarea al automatizar el descubrimiento, la clasificación y el seguimiento de los activos de hardware y software. En lugar de depender de métodos manuales tradicionales, a menudo propensos a errores, la IA aprovecha técnicas avanzadas como el aprendizaje automático para analizar el tráfico de red, la actividad de los puntos finales y los registros en la nube. Este enfoque garantiza la detección de activos no identificados o no autorizados, el resaltado de discrepancias y la actualización continua del inventario.

Las herramientas basadas en IA, como ISMS Copilot, mejoran este proceso al integrarse perfectamente con escáneres, CMDB y API en la nube. Pueden rellenar automáticamente tablas de inventario que cumplen con los estándares del NIST y generar documentación esencial, incluidos informes de activos y registros de cambios. Con su interfaz de lenguaje natural, ISMS Copilot facilita a los usuarios realizar preguntas como «¿Qué dispositivos no tienen actualizaciones de firmware?» y recibir información útil de forma inmediata. Esto no solo reduce la carga de trabajo manual, sino que también mejora la precisión, manteniendo su inventario de activos en perfecta sincronía con los estándares NIST.

¿Cómo ayuda la IA a identificar y reducir los sesgos en los sistemas de IA?

La IA desempeña un papel importante en la detección y corrección de sesgos dentro de los sistemas de inteligencia artificial. El Marco de Gestión de Riesgos de IA del NIST destaca la equidad como uno de los principios clave de una IA fiable, junto con la seguridad, la transparencia y la privacidad. Mediante el uso de herramientas de IA, las organizaciones pueden examinar grandes conjuntos de datos, predicciones y metadatos para descubrir patrones de trato desigual, como tasas de error más altas que afectan de manera desproporcionada a determinados grupos demográficos. Estas herramientas también aplican métricas de equidad estadística y ofrecen información útil para abordar los problemas identificados.

Los asistentes basados en IA, como ISMS Copilot, van un paso más allá al supervisar activamente los sistemas de IA para garantizar el cumplimiento de los controles del NIST. Pueden detectar documentación faltante, señalar fuentes de datos no probadas o identificar lagunas en los procesos de pruebas de sesgo. Al ofrecer plantillas personalizadas y orientación paso a paso, estas herramientas transforman el cumplimiento de una lista de verificación estática en un flujo de trabajo interactivo. Esto facilita a las organizaciones abordar los sesgos, garantizando que sus sistemas de IA no solo cumplan con la normativa, sino que también sean más justos y fiables.

¿Cómo puede la IA ayudar a automatizar las evaluaciones de control de privacidad según los estándares del NIST?

La IA elimina las complicaciones de las evaluaciones de control de la privacidad mediante el análisis del Marco de Privacidad del NIST y los controles relacionados con la privacidad de la norma SP 800-53. A continuación, alinea estos controles con los flujos de datos, los sistemas y las políticas de su organización. Al escanear los archivos de configuración, los registros de API y la documentación, crea un mapa en tiempo real que vincula los controles con los activos, identificando automáticamente problemas como la falta de cifrado o los controles de acceso obsoletos.

ISMS Copilot, a menudo denominado «el ChatGPT de la norma ISO 27001», incorpora esta funcionalidad a las normas del NIST. Por ejemplo, se le puede pedir que evalúe un control específico, como el control de privacidad AU-3 de la norma NIST 800-53. En respuesta, genera listas de verificación personalizadas, pasos para recopilar pruebas y planes de corrección. Esto elimina el tedioso trabajo manual y ofrece información instantánea, precisa y útil para agilizar los esfuerzos de cumplimiento.