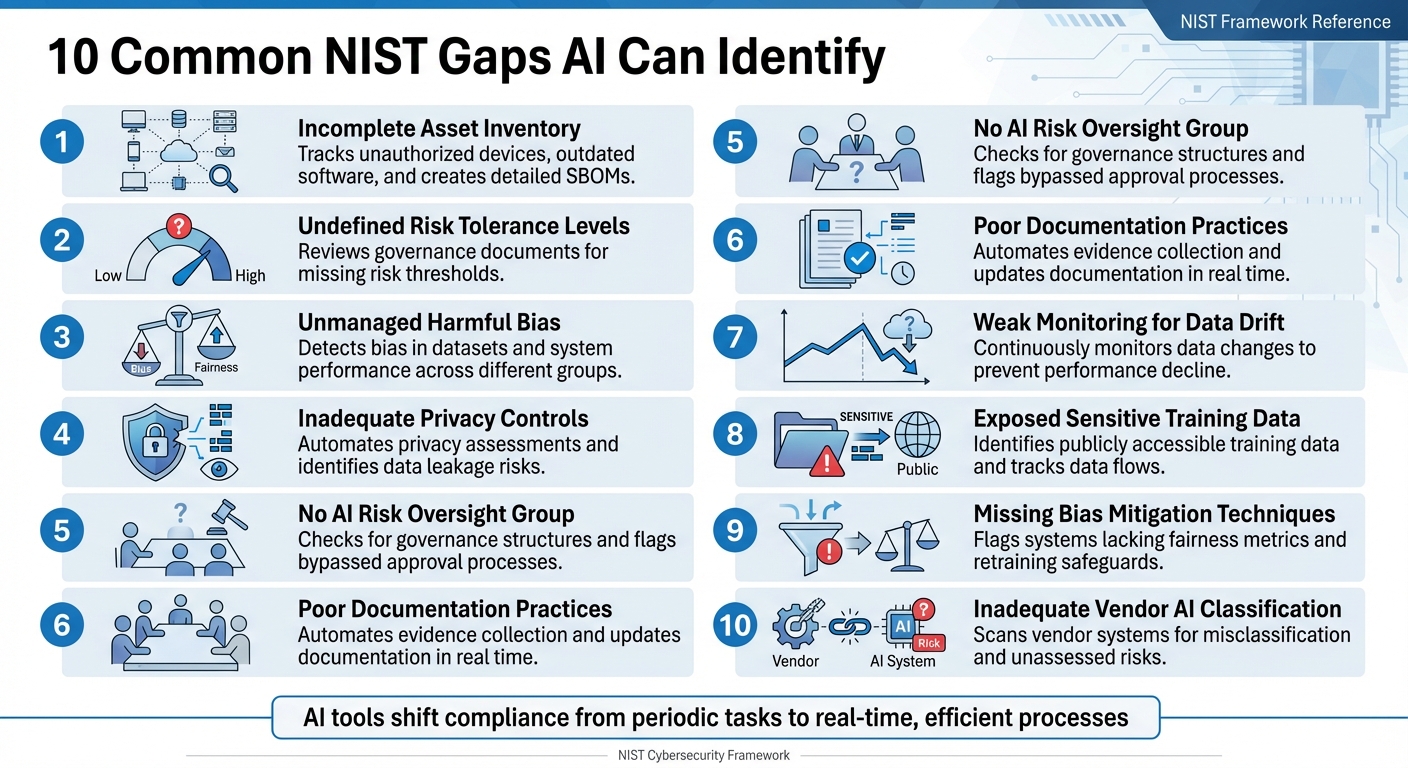

Les organisations ont souvent du mal à se conformer pleinement au cadre de cybersécurité du NIST (CSF), en particulier à sa dernière version, CSF 2.0. Les audits manuels sont lents et sujets à des erreurs, laissant des lacunes dans des domaines tels que le suivi des actifs, la gestion des risques et les contrôles de confidentialité. Les outils basés sur l'IA changent la donne en automatisant les contrôles de conformité, en assurant une surveillance continue et en identifiant les lacunes en temps réel. Voici 10 lacunes courantes en matière de conformité au NIST que l'IA peut combler :

- Inventaire des actifs incomplet: l'IA suit les appareils non autorisés, les logiciels obsolètes et crée des nomenclatures logicielles détaillées (SBOM).

- Niveaux de tolérance au risque non définis: l'IA examine les documents de gouvernance afin de détecter les seuils de risque manquants.

- Biais non géré: l'IA détecte les biais dans les ensembles de données et les performances du système entre différents groupes.

- Contrôles de confidentialité inadéquats: l'IA automatise les évaluations de confidentialité et identifie les risques tels que les fuites de données.

- Pas de groupe de surveillance des risques liés à l'IA: l'IA vérifie les structures de gouvernance et signale les processus d'approbation contournés.

- Pratiques de documentation inadéquates: l'IA automatise la collecte de preuves et met à jour la documentation en temps réel.

- Faible surveillance des dérives de données: les outils d'IA surveillent en permanence les changements de données afin d'éviter toute baisse de performances.

- Données d'entraînement sensibles exposées: l'IA identifie les risques tels que les données d'entraînement accessibles au public et suit les flux de données.

- Techniques d'atténuation des biais manquantes: l'IA signale les systèmes qui ne disposent pas de mesures d'équité et de garanties de recyclage.

- Classification inadéquate des fournisseurs par l'IA: l'IA analyse les systèmes des fournisseurs afin de détecter les erreurs de classification et les risques non évalués.

Les outils d'IA tels que ISMS Copilot rationalisent la conformité en automatisant l'analyse des lacunes, en alignant les contrôles sur les normes NIST et en générant une documentation prête pour l'audit. La conformité passe ainsi d'une tâche périodique à un processus efficace en temps réel.

10 lacunes courantes en matière de conformité NIST que l'IA peut identifier et combler

GRC - Analyse des écarts 101 à l'aide des contrôles de conformité NIST RMF et CIS

1. Inventaire incomplet des actifs

Il est essentiel de disposer d'un inventaire complet des actifs pour répondre aux exigences de conformité du NIST. Pourtant, de nombreuses organisations ont du mal à garder une trace de tous les appareils, applications et composants logiciels qu'elles utilisent. Lorsque les actifs ne sont pas suivis, ils créent des vulnérabilités que les pirates peuvent exploiter.

Un copilote NIST 800-53 peut vous aider en comparant l'état réel de votre réseau à son état souhaité. Une analyse continue met en évidence tout écart par rapport à votre liste d'actifs approuvés, ce qui facilite la détection de problèmes tels que les appareils non autorisés ou les logiciels obsolètes qui ne disposent pas des correctifs de sécurité essentiels. Ce processus continu renforce non seulement la gestion des risques, mais fournit également des informations précieuses sur la sécurité de votre réseau.

« La fonctionnalité SWAM vise principalement à gérer les risques créés par les logiciels non gérés ou non autorisés sur un réseau. Les logiciels non gérés ou non autorisés constituent une cible que les pirates peuvent utiliser comme plate-forme pour attaquer les composants du réseau. » – NIST IR 8011 Vol. 3

Au-delà de la numérisation, les tableaux de bord CDM offrent une visibilité en temps réel sur votre inventaire d'actifs, passant ainsi d'audits statiques et obsolètes à une surveillance continue. Les systèmes d'IA peuvent également créer automatiquement une nomenclature logicielle (SBOM) détaillée pour chaque version logicielle, répertoriant chaque composant et chaque dépendance, qu'elle soit directe ou indirecte. Cette fonctionnalité est de plus en plus importante, car près de 220 000 organisations américaines doivent se conformer aux normes CMMC, dont 80 000 sont soumises à des contrôles de niveau 2 conformes à la norme NIST SP 800-171.

Pour améliorer votre inventaire des actifs, envisagez d'utiliser des balises d'identification logicielle (SWID) afin d'automatiser la détection des logiciels sur votre réseau. Vous pouvez également mettre en place une liste blanche automatisée afin de vous assurer que seuls les logiciels autorisés peuvent être exécutés. Pour les systèmes d'IA, il est essentiel d'inventorier non seulement le matériel, mais également les intégrations tierces dont ils dépendent, car ces composants externes peuvent présenter des risques supplémentaires.

2. Niveaux de tolérance au risque non définis

De nombreuses organisations reconnaissent les risques associés à l'IA, mais souvent, elles ne parviennent pas à établir des seuils clairs pour déterminer ce qui est acceptable. Sans ces limites définies, les équipes peuvent avoir du mal à déterminer quand aller de l'avant ou mettre un projet en pause. C'est là que les outils d'IA s'avèrent utiles. Grâce au traitement du langage naturel, les assistants ISMS inter-cadres peuvent examiner les politiques, les stratégies de gestion des risques et les cadres de gouvernance afin de confirmer si des critères spécifiques, tels que des limites quantitatives ou qualitatives, ont été fixés pour différentes applications d'IA. Par exemple, les systèmes qui traitent des données sensibles, telles que les informations personnelles identifiables (PII), nécessitent des seuils plus stricts pour garantir la sécurité et la conformité. Lorsque ces mesures de protection font défaut, des mesures correctives immédiates deviennent nécessaires, comme le souligne le NIST.

« Dans la mesure où les défis liés à la définition des tolérances au risque liées à l'IA restent sans réponse, il peut exister des contextes dans lesquels un cadre de gestion des risques n'est pas encore facilement applicable pour atténuer les risques négatifs liés à l'IA. » - NIST AI RMF 1.0

Le NIST définit la tolérance au risque comme « la disposition d'une organisation ou d'un acteur de l'IA à assumer le risque afin d'atteindre ses objectifs ». Les outils d'IA jouent un rôle crucial dans l'analyse des documents de gouvernance afin de vérifier l'existence de critères d'acceptation des risques clairement documentés, qu'il s'agisse de limites numériques ou de limites qualitatives plus larges. Cependant, le cadre de gestion des risques liés à l'IA du NIST, introduit le 26 janvier 2023, n'impose pas de niveaux de tolérance spécifiques. Il souligne plutôt l'importance d'identifier les lacunes - telles que l'absence de documentation sur les risques résiduels ou des stratégies de gestion des risques vagues - qui pourraient exposer les organisations à des risques.

Le NIST fournit des directives claires pour ce type de scénario :

« Dans les cas où un système d'IA présente des niveaux de risque négatifs inacceptables... son développement et son déploiement doivent être suspendus de manière sécurisée jusqu'à ce que les risques puissent être suffisamment maîtrisés. » - NIST AI RMF 1.0

3. Préjugés nuisibles non gérés

Les biais dans les systèmes d'IA proviennent de l'interaction entre le code, les données d'entraînement et le contexte social plus large. Sans politiques de conformité appropriées, ces systèmes peuvent involontairement aggraver les inégalités existantes, voire créer de nouveaux schémas de discrimination. Cela a des conséquences concrètes dans des domaines tels que la santé, le recrutement et la finance. Le problème est aggravé par la complexité des systèmes d'IA, qui impliquent souvent d'innombrables points de décision, rendant presque impossible l'identification et la correction manuelles des biais. Les organisations font souvent appel à un assistant de conformité IA pour gérer ces workflows complexes et multi-étapes.

« Sans contrôles appropriés, les systèmes d'IA peuvent amplifier, perpétuer ou exacerber des résultats inéquitables ou indésirables pour les individus et les communautés. » - NIST AI RMF 1.0

Les outils d'IA s'attaquent aux biais préjudiciables grâce à des processus tels que le test, l'évaluation, la vérification et la validation (TEVV), comme le décrit la fonction MEASURE du NIST AI RMF. Ces processus évaluent si les ensembles de données d'entraînement correspondent à leur objectif et reflètent les conditions sociétales actuelles. La surveillance automatisée joue ici un rôle clé, en identifiant les « dérives de données », c'est-à-dire les changements dans les données d'entrée qui peuvent avoir un impact sur les performances du système et introduire de nouveaux biais qui n'étaient peut-être pas présents lors des tests initiaux.

Ce processus de détection va au-delà du simple calcul de chiffres. Les outils d'IA évaluent les performances des systèmes dans différents sous-groupes, en reconnaissant que même les personnes qui n'utilisent pas directement le système peuvent être affectées. Cette approche, souvent appelée évaluation socio-technique, prend en compte non seulement la conception technique, mais aussi la manière dont elle interagit avec les normes sociales et le comportement humain pour produire des inégalités. Pour garantir l'objectivité, le NIST préconise une répartition claire des responsabilités : les équipes qui élaborent les modèles d'IA doivent être distinctes de celles qui les vérifient et les valident. Cette configuration permet des évaluations plus impartiales et une surveillance continue des biais dans tous les groupes d'utilisateurs.

Une autre stratégie clé pour gérer les biais consiste à améliorer le suivi des données. Par exemple, les organisations qui utilisent des outils de visibilité natifs de l'IA ont signalé une augmentation stupéfiante de 1 660 % de leur capacité à surveiller les activités de traitement des données en seulement trois semaines après leur mise en œuvre. Ces outils cartographient les « parcours des données », en retraçant leur flux depuis leur source jusqu'aux modèles d'IA. Ce faisant, ils peuvent prédire et prévenir les violations potentielles en temps réel. Cela est essentiel, car l'IA traite les données à une vitesse bien supérieure à celle que peuvent gérer les équipes manuelles. Le suivi de ces flux de données est essentiel pour détecter les changements susceptibles d'entraîner l'apparition ou l'aggravation de biais avant qu'ils ne causent des dommages.

4. Contrôles de confidentialité inadéquats

La rapidité et l'ampleur des systèmes d'IA font des failles en matière de confidentialité une préoccupation majeure, d'autant plus que la surveillance manuelle peine à suivre le rythme. Sans mesures de protection adéquates, les organisations risquent d'exposer des informations personnelles identifiables (PII) par le biais de fuites de données d'entraînement, d'accès non autorisés ou de divulgations involontaires dans les résultats des modèles. Le recours aux API pour l'ingestion et l'inférence des données augmente encore davantage la surface d'attaque, rendant indispensables des contrôles de confidentialité robustes.

Pour relever ces défis, les outils d'IA, notamment les assistants de conformité spécialisés, automatisent désormais les évaluations des contrôles de confidentialité à l'aide de formats lisibles par machine tels que OSCAL. Ces outils évaluent en permanence les contrôles décrits dans des cadres tels que NIST SP 800-53, en utilisant des formats tels que JSON, XML et YAML. Il convient de noter que le 27 août 2025, le NIST a publié la version 5.2.0 de la norme SP 800-53, qui intègre pleinement les contrôles de confidentialité dans le catalogue plus large des contrôles de sécurité, s'éloignant ainsi de l'approche autonome antérieure.

« Le fait de se pencher sur la fonctionnalité et l'assurance contribue à garantir que les produits informatiques et les systèmes qui s'appuient sur ces produits sont suffisamment fiables. » - Groupe de travail conjoint, NIST SP 800-53 Rev. 5

Les outils automatisés se concentrent sur la famille de contrôles PT (PII Processing and Transparency) afin d'identifier les risques liés à l'utilisation non autorisée, à la divulgation ou à la désanonymisation des informations personnelles identifiables. Ils permettent également de détecter les API et les IA fantômes que les audits manuels négligent souvent. En mettant en œuvre la « politique en tant que code », les organisations peuvent convertir les exigences complexes de la norme NIST SP 800-53 en règles opérationnelles en temps réel. Ce processus est rationalisé lorsque les organisations forment leurs assistants de conformité IA à des modèles de haute précision conçus pour la GRC. Ces règles suppriment automatiquement les données sensibles des invites et des sorties de l'IA avant qu'elles ne soient traitées par le modèle.

De plus, le logiciel Dioptra du NIST prend en charge les exercices de red teaming, aidant les organisations à tester les contrôles de confidentialité et de sécurité dans des conditions adverses. Ces simulations permettent de mesurer les pertes de performance et d'identifier des vulnérabilités spécifiques. Cela est particulièrement important étant donné que le profil d'IA générative du NIST AI RMF décrit 12 risques uniques ou accrus associés à l'IA, notamment des problèmes de confidentialité des données tels que les fuites et la désanonymisation non autorisée. Le 14 avril 2025, le NIST a encore insisté sur ces questions en publiant le projet de cadre de confidentialité 1.1, qui traite spécifiquement des risques liés à l'IA en matière de confidentialité, tels que les attaques par inférence et l'amplification des biais.

5. Pas de groupe de surveillance des risques liés à l'IA

L'un des principaux défis de la gestion des risques liés à l'IA est l'absence d'un groupe de surveillance dédié. Sans un tel comité, la gouvernance et la responsabilité sont souvent négligées, ce qui conduit à des efforts fragmentés et moins prioritaires. Aujourd'hui, des outils avancés exploitant le traitement du langage naturel (NLP) peuvent aider à combler cette lacune en analysant les politiques, les chartes et les procès-verbaux des réunions de l'organisation. Ces outils permettent de confirmer l'existence d'un groupe officiel de surveillance des risques liés à l'IA et de garantir la conformité avec la fonction « Govern » du NIST AI RMF, en particulier Govern 1.2, qui souligne la nécessité de structures claires en matière de gouvernance et de responsabilité.

Les systèmes basés sur l'IA examinent également les organigrammes et les systèmes de gestion des identités afin d'identifier les rôles de supervision formels dans le cadre de la gestion des risques liés à l'IA. Les plateformes de gouvernance ajoutent un niveau de protection supplémentaire en signalant les projets qui contournent les processus d'approbation formels. Cela garantit une supervision continue, un élément essentiel du respect du RMF du NIST. La fonction « Gouvernance » sert de base et influence toutes les autres fonctions du RMF, telles que la cartographie, la mesure et la gestion. Cette approche interconnectée renforce l'ensemble du cadre.

« Sans responsabilité clairement définie, les efforts de gestion des risques liés à l'IA peuvent devenir fragmentés ou perdre leur priorité, exposant ainsi l'organisation à des risques. » - Kezia Farnham, directrice principale, Diligent

L'urgence d'une surveillance adéquate est soulignée par la croissance rapide des investissements et de la réglementation dans le domaine de l'IA. En 2024, les investissements du secteur privé américain dans l'IA ont dépassé les 100 milliards de dollars, tandis que les mentions de l'IA dans la législation mondiale ont augmenté de 21,3 % dans 75 pays depuis 2023, soit une multiplication par neuf depuis 2016. Sans mécanismes de surveillance formels, les organisations risquent de ne plus être en conformité avec les nouvelles réglementations, telles que la loi européenne sur l'IA et le décret américain 14110, qui soulignent l'importance de la surveillance humaine et de la gestion des risques vérifiable.

Pour combler cette lacune, les organisations devraient former un comité interfonctionnel chargé des risques liés à l'IA, qui comprendrait des dirigeants clés tels que le directeur juridique, le responsable de la sécurité des systèmes d'information (RSSI), le directeur des risques et les responsables de l'IA/ML. Confier la responsabilité du RMF IA à un seul cadre supérieur, souvent le directeur des risques ou le directeur juridique, peut permettre de centraliser davantage la responsabilité. De plus, l'adoption d'un assistant de conformité IA spécialement conçu peut rationaliser ce processus, en automatisant la répartition des rôles et des responsabilités et en remplaçant les feuilles de calcul manuelles obsolètes par des systèmes de surveillance continue.

6. Mauvaises pratiques en matière de documentation

S'ajoutant aux problèmes antérieurs liés au suivi et à la surveillance des actifs, la mauvaise documentation compromet davantage les efforts de conformité. Les lacunes en matière de documentation sont à la fois répandues et coûteuses lorsqu'il s'agit de la conformité NIST. Pas moins de 86 % des organisations manquent de visibilité sur leurs flux de données d'IA, ce qui entraîne d'importantes lacunes en matière de documentation et d'audit qui peuvent poser problème lors des contrôles réglementaires. Par exemple, lorsque les auditeurs demandent les journaux des interactions de l'IA impliquant des données personnelles, de nombreuses organisations ne sont pas en mesure de les fournir. Ce manquement enfreint des réglementations clés telles que l'article 30 du RGPD, la section 1798.130 du CCPA et l'article 164.312 de l'HIPAA.

Les plateformes de conformité basées sur l'IA offrent une solution pratique en remplaçant les feuilles de calcul manuelles obsolètes par des tableaux de bord en temps réel. Ces tableaux de bord signalent automatiquement les preuves manquantes et les problèmes de documentation. Ils utilisent également une surveillance continue des contrôles pour détecter les « dérives », c'est-à-dire les cas où la documentation ou les politiques actuelles ne correspondent plus à l'état réel des systèmes ou des infrastructures. Des outils automatisés capturent les configurations et les journaux en temps réel, créant ainsi des pistes d'audit complètes.

« Traiter chaque changement, déploiement et incident comme un événement à documenter garantit une accumulation régulière de preuves bien plus fiables qu'un effort précipité après coup. » - Abnormal AI

Le principe « documenter au fur et à mesure » renforce la conformité en capturant les preuves en temps réel. En s'intégrant à des outils tels que les wikis à contrôle de version et les systèmes de tickets, l'IA garantit que les approbations et les captures d'écran sont jointes aux demandes d'extraction. Cela est particulièrement important étant donné que seulement 17 % des organisations ont mis en place des contrôles de sécurité automatisés basés sur l'IA capables de fournir les journaux requis pour les audits réglementaires.

Les organisations qui exploitent des plateformes de conformité automatisées bénéficient d'avantages majeurs, notamment la réduction des cycles de révision de plusieurs semaines à quelques heures seulement et la diminution significative de la charge de travail liée à la conformité. Ces outils comparent également le « profil actuel » d'une organisation au « profil cible » du NIST, identifiant ainsi les lacunes en matière de protection et de documentation. En automatisant le processus « Identifier-Évaluer-Catégoriser », ils contribuent à garantir que les inventaires d'actifs et les classifications des risques restent à jour. Cette approche continue de la documentation joue un rôle clé dans le maintien de la conformité NIST.

sbb-itb-4566332

7. Faiblesse du suivi des dérives des données

La dérive des données se produit lorsque les données sur lesquelles un système d'IA a été formé changent au fil du temps, entraînant une baisse des performances et de la fiabilité. Avec plus de 75 % des organisations utilisant désormais l'IA dans au moins une fonction métier, le fait de ne pas surveiller ces changements crée un risque sérieux de non-conformité, auquel les outils basés sur l'IA sont bien équipés pour faire face. Pour résoudre ce problème, il faut des solutions de surveillance plus avancées, comme indiqué ci-dessous.

Dans la pratique, l'IA fonctionne souvent comme une « boîte noire », ce qui rend plus difficile la détection des dysfonctionnements. 45 % des organisations citent les préoccupations liées à l'exactitude ou au biais des données comme un obstacle majeur à l'adoption de l'IA. Pourtant, beaucoup ne disposent toujours pas des outils nécessaires à une surveillance continue, ce qui les rend vulnérables à la dérive des données. Contrairement aux contrôles manuels, la surveillance continue permet une analyse en temps réel, détectant les problèmes avant qu'ils ne s'aggravent.

« Les systèmes d'IA [...] peuvent être entraînés à partir de données susceptibles d'évoluer au fil du temps, parfois de manière significative et inattendue, ce qui peut affecter leur fonctionnalité et leur fiabilité d'une manière difficile à comprendre. »

Pour remédier à la dérive des données, les outils avancés d'IA-SPM peuvent détecter automatiquement les modèles d'IA déployés, identifier les « IA fantômes » et cartographier les ensembles de données d'entraînement et d'inférence, y compris les magasins de documents et les bases de données vectorielles. Ces outils signalent également les erreurs de configuration, telles que les données d'entraînement accessibles au public, qui pourraient présenter des risques pour la sécurité.

Par exemple, Net Solutions a récemment collaboré avec une entreprise nord-américaine de nettoyage commercial afin de mettre en place une gouvernance IA pour un assistant commercial en ligne. Grâce à des outils de surveillance en temps réel tels qu'AWS CloudWatch et DataDog, ainsi qu'à des pipelines automatisés intégrés aux alertes Zoho Desk, l'entreprise est passée d'une preuve de concept à une solution IA conforme et évolutive en seulement six semaines.

Akash Lomas, technologue chez Net Solutions, souligne l'importance de la surveillance :

« La mesure devient particulièrement cruciale dans les environnements où l'IA façonne directement l'expérience client... sans surveillance continue, ces systèmes peuvent dériver et proposer des contenus non pertinents, biaisés ou trompeurs ».

Ignorer la dérive des données peut avoir des conséquences importantes : baisse des performances du système, amendes réglementaires et perte de confiance. En outre, les cyberattaques coûtent en moyenne 4,45 millions de dollars par an aux entreprises.

8. Données de formation sensibles exposées

Le risque d'exposition des données d'entraînement sensibles est une préoccupation majeure, en particulier en matière de violation de la conformité. Selon le NIST, l'IA générative présente 12 risques distincts, parmi lesquels les problèmes de confidentialité des données, tels que la fuite et la divulgation non autorisée d'informations personnelles, constituent une préoccupation majeure. De nombreuses organisations ont du mal à suivre la localisation de leurs données d'entraînement IA et à en garantir la sécurité.

Pour remédier à cela, les outils de gestion de la sécurité de l'IA (AI-SPM) sont devenus indispensables. Ces outils peuvent identifier automatiquement les modèles d'IA déployés et localiser les ensembles de données utilisés pour l'entraînement sur les plateformes cloud, y compris le stockage de documents et les bases de données vectorielles. Ils signalent également les vulnérabilités, telles que les données d'entraînement accessibles au public ou les points de terminaison d'applications ouverts. Mahesh Nawale, responsable marketing produit chez Zscaler, souligne l'importance de ces outils :

« Zscaler AI-SPM localise automatiquement les ensembles de données utilisés dans le cadre de l'entraînement et de l'inférence de l'IA dans votre environnement cloud, y compris les données, les magasins de documents et les bases de données vectorielles. Il signale les erreurs de configuration, telles que les données d'entraînement accessibles au public, fournissant ainsi à vos équipes de sécurité les informations nécessaires pour enquêter, remédier et prouver la conformité. »

Les outils d'IA ne se contentent pas d'identifier les erreurs de configuration. Ils surveillent également le comportement des modèles afin de détecter les menaces potentielles. Ils peuvent par exemple détecter des problèmes tels que la mémorisation de données, l'inversion de modèles ou des activités suspectes telles que des téléchargements de données volumineux ou des modifications non autorisées, qui pourraient indiquer une exfiltration de données. Les capacités d'analyse automatisées renforcent encore la sécurité en identifiant les informations sensibles (telles que les données biométriques, médicales ou de localisation) qui n'ont pas été correctement anonymisées.

Le NIST a également développé « Dioptra », une solution logicielle qui aide les organisations à tester les modèles d'IA contre les cyberattaques. Elle mesure l'impact des attaques sur les performances des modèles et identifie les scénarios dans lesquels les données d'entraînement pourraient être compromises.

Katerina Megas, responsable de programme au NIST, souligne le défi croissant que cela représente :

« L'IA crée de nouveaux risques de réidentification, non seulement en raison de sa puissance analytique sur des ensembles de données disparates, mais aussi en raison des fuites de données potentielles issues de l'entraînement des modèles ».

Avec les énormes ensembles de données utilisés pour l'entraînement des grands modèles linguistiques, les tests automatisés continus ne sont plus facultatifs : ils sont indispensables pour protéger les informations sensibles.

9. Techniques d'atténuation des biais manquantes

Lorsque les systèmes d'IA ne disposent pas de méthodes appropriées pour lutter contre les biais, ils risquent d'amplifier les résultats injustes et de créer d'importants problèmes de conformité. Selon le NIST, la gestion des biais préjudiciables est l'une des sept caractéristiques essentielles d'un système d'IA fiable. Les cadres traditionnels de gestion des risques ne permettent pas de traiter efficacement les biais de l'IA, ce qui rend indispensables des stratégies d'atténuation spécialisées. Si les sections précédentes traitaient de la détection des biais, leur lutte efficace nécessite des contrôles clairs et des efforts de formation continue. Il ne suffit pas de simplement identifier les biais, il faut également mettre en place des stratégies à long terme pour les contrer.

Les outils d'IA jouent un rôle clé dans la détection des lacunes dans les contrôles des biais. Ils signalent des problèmes tels que l'absence de mesures d'équité (par exemple, les ratios d'impact disparates ou les différences de taux de faux positifs), les systèmes qui ne font pas l'objet de tests adversaires ou de red teaming IA, et les modèles sans réentraînement programmé, ce qui les rend vulnérables à la dérive des données.

« Sans contrôles appropriés, les systèmes d'IA peuvent amplifier, perpétuer ou exacerber des résultats inéquitables ou indésirables pour les individus et les communautés. » – NIST AI RMF 1.0

Pour relever ces défis, les plateformes de gouvernance de l'IA effectuent des analyses automatisées afin de détecter les lacunes en matière de conformité sur la base des directives RMF du NIST relatives à l'IA. Elles garantissent que les organisations ont mis en place les mesures de protection nécessaires, telles que des filtres de contenu, des protocoles de correction des biais et d'autres garde-fous imposés par des normes telles que la norme NIST AI 600-1. Ces plateformes retracent également la provenance des données afin de confirmer que les ensembles de données d'entraînement ne présentent aucun problème susceptible d'entraîner des résultats biaisés. De plus, les outils de gestion de la posture de sécurité de l'IA (AI-SPM) identifient tous les modèles d'IA déployés, y compris les systèmes « shadow AI » qui ont pu contourner complètement les tests d'équité.

Les systèmes d'IA prenant des milliards de décisions, les biais non détectés peuvent éroder la confiance du public, porter atteinte aux libertés civiles et entraîner des sanctions réglementaires. Il convient de noter que les mentions relatives à la législation sur l'IA ont augmenté de 21,3 % à l'échelle mondiale depuis 2023. Ces risques soulignent la nécessité urgente d'une surveillance continue et automatisée afin de garantir l'équité et la responsabilité.

10. Classification inadéquate des fournisseurs par l'IA

Lorsque les organisations ne classent pas correctement les systèmes d'IA tiers, elles s'exposent à des risques de conformité qu'elles ne voient peut-être même pas venir. Le problème ? Les indicateurs de risque des fournisseurs ne correspondent souvent pas aux cadres de risque internes des entreprises. Si les fournisseurs sont mal classés, il est impossible d'appliquer les contrôles appropriés ou de déterminer si leur label « à faible risque » correspond réellement à la tolérance au risque de votre organisation. Cette inadéquation souligne la nécessité de disposer d'outils automatisés capables de vérifier en temps réel la classification des fournisseurs.

C'est là qu'interviennent les outils basés sur l'IA, qui automatisent le processus d'identification des lacunes en matière de classification. En analysant les contrats des fournisseurs et les spécifications techniques, ces outils repèrent les systèmes mal classés et signalent les composants IA tiers non évalués, comme indiqué dans les fonctions Govern 6.1 et Map 4.1 du NIST AI RMF. Ils détectent également les systèmes qui manquent de transparence sur des éléments critiques tels que les modèles pré-entraînés, les pipelines de données ou les processus de développement.

« Les risques peuvent provenir à la fois des données, des logiciels ou du matériel tiers eux-mêmes et de la manière dont ils sont utilisés. » – NIST AI RMF 1.0

Le profil du cadre de cybersécurité du NIST pour l'IA, élaboré avec la contribution de plus de 6 500 participants, souligne l'importance de la visibilité de la chaîne d'approvisionnement. Les outils basés sur l'IA aident à maintenir des inventaires en temps réel des systèmes tiers, en cartographiant la chaîne d'approvisionnement de l'IA afin de découvrir les composants non classifiés ou non vérifiés. Ces outils exposent les vulnérabilités cachées dans les logiciels, le matériel ou les sources de données qui ne pourraient apparaître qu'au moment du déploiement. Grâce à la classification automatisée des fournisseurs, les organisations peuvent obtenir une vue d'ensemble de leur paysage de risques liés à l'IA, conformément aux directives du NIST.

Un autre avantage de l'automatisation est sa capacité à hiérarchiser les évaluations des fournisseurs en fonction de la sensibilité des données. Par exemple, les systèmes qui traitent des informations personnelles identifiables ou qui interagissent directement avec les utilisateurs sont signalés pour faire l'objet d'un examen plus approfondi. Cette approche reconnaît qu'un système considéré comme présentant un faible risque dans un contexte donné, comme le traitement des données de capteurs physiques, peut présenter un risque élevé dans un autre contexte, comme la gestion d'informations médicales protégées. Sans cette surveillance automatisée, les entreprises risquent de gaspiller des ressources sur des systèmes à faible risque tout en laissant les outils d'IA à haut risque insuffisamment surveillés.

Comment ISMS Copilot identifie ces lacunes

ISMS Copilot adopte une approche spécifique au cadre pour identifier les lacunes dans la conformité à la norme NIST 800-53. Au lieu de parcourir Internet à la recherche de réponses, il utilise la génération augmentée par la récupération (RAG) pour extraire des informations ciblées à partir d'un ensemble de données soigneusement sélectionnées. Cet ensemble de données comprend plus de 30 cadres tels que NIST 800-53, ISO 27001, SOC 2 et GDPR, fournissant des conseils précis et concrets pour combler les lacunes en matière de conformité.

Cet outil simplifie l'analyse des écarts en cartographiant les contrôles selon plusieurs normes, en créant une documentation prête à être utilisée par les auditeurs et en décomposant les rapports volumineux. Avec ISMS Copilot One, les utilisateurs peuvent télécharger des documents de conformité, même ceux qui dépassent 20 pages, pour une analyse automatisée. Actuellement, plus de 600 consultants s'appuient sur cet outil pour répondre à leurs besoins en matière de conformité à la sécurité de l'information. Voici une comparaison rapide des fonctionnalités spécialisées d'ISMS Copilot par rapport aux outils d'IA à usage général :

| Fonctionnalité | Copilote ISMS | IA à usage général |

|---|---|---|

| Ensemble de données | Axé sur la conformité en matière de sécurité de l'information | Connaissances générales étendues |

| Précision | Fournit des conseils spécifiques au cadre | Souvent vague ou trop générique |

| Préparation à l'audit | Crée une documentation prête à être vérifiée par les auditeurs | Non adapté aux audits formels |

| Confidentialité des données | Conforme à la norme SOC 2 Type II ; aucune formation sur les données utilisateur | Peut utiliser les entrées utilisateur pour la formation |

| Analyse documentaire | Effectue une analyse détaillée des écarts pour les rapports volumineux. | Limité au traitement de texte de base |

Afin de protéger les informations des clients, ISMS Copilot fournit des espaces de travail dédiés qui isolent et sécurisent les projets. Toutes les données sont stockées dans des bases de données conformes à la norme SOC 2 Type II et bénéficiant d'un chiffrement de bout en bout, ce qui garantit que les documents ou conversations téléchargés ne sont jamais utilisés pour entraîner ses modèles d'IA.

Pour les organisations qui s'attaquent aux analyses des écarts NIST 800-53, ISMS Copilot propose des mesures claires et concrètes pour mettre en œuvre des contrôles et répondre aux exigences FISMA. Vous pouvez découvrir l'offre gratuite sur chat.ismscopilot.com, les formules payantes commençant à 20 $ par mois.

Conclusion

L'IA a transformé la conformité NIST, qui était auparavant un processus périodique et réactif, en un système proactif et en temps réel. En analysant l'ensemble des données, l'IA peut identifier les problèmes potentiels avant qu'ils ne s'aggravent. Grâce à l'automatisation basée sur l'IA, les organisations peuvent se préparer à tout moment à un audit en automatisant la collecte de preuves tout en se conformant aux exigences de conformité en constante évolution.

Des outils tels que la politique en tant que code et l'assurance continue permettent d'automatiser les contrôles NIST, en traitant les problèmes dès le début du processus de développement. Les outils basés sur l'IA peuvent rapidement détecter les anomalies dans divers environnements, assurant ainsi une surveillance centralisée de plusieurs cadres de conformité. Ces capacités sont au cœur des solutions proposées par ISMS Copilot.

ISMS Copilot assure une conformité continue grâce à son approche RAG (rouge-orange-vert), en s'appuyant sur un ensemble de données sélectionnées qui couvre des cadres tels que NIST 800-53, ISO 27001, SOC 2 et bien d'autres encore. Ses fonctionnalités comprennent l'analyse automatisée des écarts, la cartographie inter-cadres et la documentation prête pour l'audit, garantissant ainsi que les organisations restent en conformité avec les normes NIST en constante évolution.

En plus de ces avantages, ISMS Copilot prend en charge plusieurs cadres, ce qui est essentiel pour les programmes de sécurité complexes d'aujourd'hui. Les organisations peuvent découvrir gratuitement ces outils de conformité basés sur l'IA en se rendant sur chat.ismscopilot.com.

Foire aux questions

Comment l'IA simplifie-t-elle la gestion des stocks d'actifs pour la conformité NIST ?

Le maintien d'un inventaire précis et à jour des actifs est un élément essentiel du cadre de cybersécurité du NIST (par exemple, ID.AM-1) et des contrôles NIST 800-53. L'IA simplifie cette tâche en automatisant la découverte, la classification et le suivi des actifs matériels et logiciels. Au lieu de s'appuyer sur des méthodes manuelles traditionnelles, souvent sujettes à des erreurs, l'IA exploite des techniques avancées telles que l'apprentissage automatique pour analyser le trafic réseau, l'activité des terminaux et les journaux cloud. Cette approche garantit la détection des actifs non identifiés ou non autorisés, la mise en évidence des divergences et la mise à jour continue de l'inventaire.

Les outils basés sur l'IA, tels que ISMS Copilot, améliorent ce processus en s'intégrant de manière transparente aux scanners, aux CMDB et aux API cloud. Ils peuvent remplir automatiquement des tableaux d'inventaire conformes aux normes NIST et générer des documents essentiels, notamment des rapports sur les actifs et des journaux de modifications. Grâce à son interface en langage naturel, ISMS Copilot permet aux utilisateurs de poser facilement des questions telles que « Quels appareils n'ont pas reçu les mises à jour du micrologiciel ? » et d'obtenir immédiatement des informations exploitables. Cela réduit non seulement la charge de travail manuelle, mais améliore également la précision, en maintenant votre inventaire d'actifs en parfaite synchronisation avec les normes NIST.

Comment l'IA aide-t-elle à identifier et à réduire les biais dans les systèmes d'IA ?

L'IA joue un rôle important dans la détection et la correction des biais au sein des systèmes d'intelligence artificielle. Le cadre de gestion des risques liés à l'IA du NIST met en avant l'équité comme l'un des principes clés d'une IA fiable, au même titre que la sécurité, la transparence et la confidentialité. À l'aide d'outils d'IA, les organisations peuvent passer au crible de grands ensembles de données, des prévisions et des métadonnées afin de mettre au jour des schémas de traitement inégalitaire, tels que des taux d'erreur plus élevés qui affectent de manière disproportionnée certains groupes démographiques. Ces outils appliquent également des mesures statistiques d'équité et fournissent des informations exploitables pour remédier aux problèmes identifiés.

Les assistants basés sur l'IA, tels que ISMS Copilot, vont encore plus loin en surveillant activement la conformité des systèmes d'IA aux contrôles du NIST. Ils peuvent repérer les documents manquants, signaler les sources de données non testées ou identifier les lacunes dans les processus de test des biais. En proposant des modèles personnalisés et des conseils étape par étape, ces outils transforment la conformité d'une simple liste de contrôle statique en un flux de travail interactif. Cela permet aux organisations de lutter plus facilement contre les biais, en s'assurant que leurs systèmes d'IA sont non seulement conformes, mais aussi plus équitables et plus fiables.

Comment l'IA peut-elle aider à automatiser les évaluations du contrôle de la confidentialité selon les normes NIST ?

L'IA simplifie les évaluations du contrôle de la confidentialité en analysant le cadre de confidentialité du NIST et les contrôles liés à la confidentialité SP 800-53. Elle aligne ensuite ces contrôles avec les flux de données, les systèmes et les politiques de votre organisation. En analysant les fichiers de configuration, les journaux API et la documentation, elle crée une carte en temps réel reliant les contrôles aux actifs, identifiant automatiquement les problèmes tels que le cryptage manquant ou les contrôles d'accès obsolètes.

ISMS Copilot, souvent appelé « le ChatGPT de la norme ISO 27001 », apporte cette fonctionnalité aux normes NIST. Par exemple, vous pouvez lui demander d'évaluer un contrôle spécifique, tel que le contrôle de confidentialité AU-3 de la norme NIST 800-53. En réponse, il génère des listes de contrôle personnalisées, des étapes pour la collecte de preuves et des plans de remédiation. Cela élimine les tâches manuelles fastidieuses et offre des informations instantanées, précises et exploitables pour rationaliser les efforts de conformité.